Abstract

While computer-based searching techniques are well-established for texts, searching techniques for musicological documents are far from being standardized yet. This stems from the significant differences between what is searched, to what these searches pertain and how musical data is represented. The following provides an overview what these differences are and outlines the perspectives for future developments in the filed of computer-based search techniques in musicology.

Im Gegensatz zu den recht etablierten computergestützten Suchverfahren in Texten sind solche Suchverfahren in der Musikwissenschaft noch weit von einer Standardisierung entfernt. Dies lässt sich darauf zurückführen, dass hinsichtlich dessen wonach gesucht wird, worin gesucht wird und hinsichtlich der elektronischen Repräsentation musikalischer Daten erhebliche Unterschiede zu herkömmlichen Texten bestehen. Im Folgenden soll aufgezeigt werden, worin diese Unterschiede bestehen und welche Perspektiven zu erkennen sind.

Die musikwissenschaftliche Analyse dient der Aufdeckung und Vermittlung struktureller und inhaltlicher musikalischer Zusammenhänge. Der Analysegegenstand kann sich dabei auf ein einzelnes Stück beschränken oder auf mehrere Werke eines oder mehrerer Komponisten, einer oder mehrerer Gattungen, einer oder mehrerer Stilrichtungen sowie einer oder mehrerer Epochen erstrecken.

Da es sich wie in allen Geisteswissenschaften sowohl bei den untersuchten Musikstücken als auch bei den darauf angewandten analytischen Theorien um von Menschen geschaffene Gebilde handelt, sind Analysen zwangsläufig immer subjektiv. Objektivität kann nur dem Anschein nach durch Bezug auf eine vorherrschende Interpretationsart einer bestimmten Theorie erreicht werden, doch selbst ein so natürlich erscheinender Vorgang wie die Reduktion eines Stückes auf eine Folge von Tonhöhen und -dauern ist bereits eine qualitative Entscheidung. Musikanalyse und Musiktheorie sind daher auf das engste miteinander verbunden. Während die Musiktheorie dabei von abstrakten Ideen ausgeht und diese an konkreten Musikstücken demonstriert oder anhand derer belegt, so geht umgekehrt die Analyse von konkreten Musikstücken aus und versucht, diese mit Hilfe abstrakter Theorien zu erklären. Der implizit oder explizit erste Schritt bei der Durchführung einer Analyse ist daher die Einnahme eines übergeordneten Standpunktes, von dem aus analysiert werden soll. Von der hierbei gewählten Theorie hängt es ab, auf welche Weise die Analyse durchgeführt wird und welche Ergebnisse möglich sind.

Beispielhaft seien hier die sehr unterschiedliche thematische und die Set-Theory-Analyse mit ihren unterschiedlichen Analysezielen und

-gegenständen vorgestellt.

Ein ›Thema‹ ist eine aufgrund ihrer melodisch und meistens auch harmonisch und rhythmisch relativ festen Gestalt wiedererkennbare musikalische Einheit, die in einem größeren Zusammenhang prägend wirkt. Es kann aus mehreren Motiven bestehen, die ihrerseits zwar ebenfalls wiedererkennbar, aber nicht für sich genommen prägend sind.[1] Nur wenn Motive außerhalb des Verbunds eines Themas auftreten, wächst ihnen die prägende Wirkung eines Themas zu, so dass sie dann ebenfalls Hauptgegenstand einer thematischen Analyse werden. Der Einfachheit halber verwende ich im Folgenden ausschließlich den Begriff ›Thema‹, wenn ich mich auf musikalisch prägende Einheiten beziehe.

Abgesehen von der Notwendigkeit, die Themen in irgendeiner Form zu wiederholen, hängt die Art und Weise, in der aus Themen musikalische Stücke aufgebaut werden, ausschließlich von der verwendeten Kompositionslehre ab.

Abb. 1 Thema aus Die Kunst der Fuge von Johann Sebastian Bach

Es gibt eine Fülle von Möglichkeiten, um die Wiederkehr eines Themas zu gestalten.[2] Neben der unveränderten Wiederholung sind dabei unter anderem wesentlich:

Veränderung der Melodik. Erweiterung oder Verringerung des Umfangs vom tiefsten zum höchsten Ton; Umkehrung.

Abb. 2 Umkehrung des Themas.

Zu jedem Halbtonschritt, den das ursprüngliche Thema aufwärts geht, geht die Umkehrung des Themas abwärts. Die Tondauern bleiben unverändert.

Veränderung der Rhythmik. Gleichmäßige Vergrößerung oder Verkleinerung aller Notendauern um einen beliebigen Faktor.

Abb. 3 Diminution (Verkleinerung) des Themas.

Alle Tondauern des ursprünglichen Themas sind um die Hälfte verringert. Aus halben Noten werden Viertelnoten und aus Viertelnoten Achtelnoten. Die Tonhöhen ändern sich nicht.

Kombination melodischer und rhythmischer Veränderungen. Verlängerung durch Anhängen zusätzlicher Noten oder Verkürzung durch Auslassung eines Teils des Themas; Modifikation eines Teils der Tonfolge (zum Beispiel Anfang und Ende gleichbleibend, Mittelteil neu); Steigerung oder Verringerung des melodischen Bewegungsimpulses; Steigerung oder Verringerung des rhythmischen Bewegungs-impulses; Kombination aus Umkehrung und Vergrößerung oder Verkleinerung.

Abb. 4 Diminuierte, rückwärts gespielte Umkehrung des Themas.

Veränderung der Notation. Obwohl abweichend und zum Teil »versteckt« notierte Themen keine Änderungen des Hörerlebnisses nach sich ziehen, spielen sie eine wichtige Rolle bei der musikwissenschaftlichen Interpretation und Identifikation von Themen.[3] Ein Thema ist »versteckt«, wenn es nicht in der Form notiert ist, die der akustische Eindruck vermuten ließe. Einige Möglichkeiten dafür sind Vermischung mit anderem (gegebenenfalls thematischem) Material; Vermischung der melodischen, harmonischen und rhythmischen Komponenten; Verteilung von aufeinanderfolgenden Abschnitten auf verschiedene Stimmen; und Verteilung einzelner aufeinanderfolgender Noten auf verschiedene Stimmen.

Abb. 5 Thema aus der Symphonie No. 6 von Peter Tschaikowsky

In der oberen Fassung ist das Thema ebenso notiert, wie es akustisch wahrgenommen wird. In der unteren Fassung vom Beginn des vierten Satzes ist der Klangeindruck derselbe, bezüglich der Notation ist es jedoch »versteckt« und alterniert zwischen den 1. Violinen (oben) und den 2. Violinen (unten).

Die Kompositionslehren, die teilweise in großer Strenge vorschreiben, in welcher Weise Themen und deren Bestandteile zu behandeln sind, lassen sich danach unterscheiden, ob sie sich auf Reihungs- oder Entwicklungsformen beziehen:

Bei Reihungsformen ändern sich die Themen nicht wesentlich, sondern werden in gleichbleibender Form aneinandergereiht. Einige Vertreter sind Liedformen (A, AB, ABA sowie AA’A BB’B AA’A) und komplexere Formen wie zum Beispiel die Rondoform (ABACABA).

Bei Entwicklungsformen kehren Themen außer in identischer Wiederholung in zahlreichen Formen melodischer und/oder rhythmischer Veränderungen wieder, wobei zusätzlich meist noch Transponierungen auftreten. Wie genau einzelne Themen und vor allem mehrere Themen im Verhältnis zueinander entwickelt werden, bestimmt sich ausschließlich aus der Gattung des Musikstücks und der dafür üblichen Formenlehren und kann nicht generell angegeben werden. Entscheidend ist jedoch in jedem Fall, dass die Themen trotz aller Veränderungen erkennbar bleiben. Entwicklungsformen sind unter anderem die zahlreichen Fugenformen (Grundschema: ||: Durchführung Zwischenspiel :|| Durchführung), und die Sonatenhauptsatzform (Grundschema: Exposition Durchführung Reprise Coda)

Der Beginn der Beschäftigung mit komplexer Musiktheorie und Formenlehre[4] fällt mit dem Übergang von musikalischer Einstimmigkeit zur Mehrstimmigkeit zusammen. Die Regeln des Kontrapunkts des 14. Jahrhunderts schreiben vor, dass zwei Stimmen nur in bestimmter Weise zueinander gesetzt werden dürfen, aber sagen noch nichts über die Behandlung von Themen. Eine rein imitative (das heißt veränderungslose) Behandlung von Themen entwickelt sich im 15. Jahrhundert, wobei die Regeln dafür in der Form der Fuge am strengsten sind. Regeln für die Gestaltung der Harmonik und Tonarten gehen auf Gioseffo Zarlino zurück, der in Le istitutione harmoniche (1558) erstmals wissenschaftlich untersucht, warum die bestehenden kontrapunktischen Regeln nicht ausreichen, um Dissonanzen zu verhindern. Im Barock entfalten sich auf dieser Grundlage kurze Zeit später in Verbindung mit einer nicht bloß imitativen Behandlung von Themen frühe Ausprägungen von weiteren Entwicklungsformen wie der Suite, dem Konzert und der Sonate. In der Klassik werden diese Formen weiterentwickelt und aus einer Folge von Sonatensätzen entsteht die Symphonie, mit der die Komplexität der thematischen Behandlung einen Höhepunkt erreicht. Weniger strenge Regeln an die Art der thematischen Entwicklung stellen Reihungsformen wie die Variation und die Phantasie.

Der thematischen Analyse geht es um die Aufdeckung und Vermittlung struktureller und inhaltlicher musikalischer Zusammenhänge. Bei der Einzelwerkanalyse wird nur ein Stück betrachtet, bei der vergleichenden Analyse können es Werke eines oder mehrerer Komponisten, einer oder mehrerer Gattungen, einer oder mehrerer Stilrichtungen sowie einer oder mehrerer Epochen sein.

Die Einzelwerkanalyse untersucht, welche Themen wo und in welcher Gestalt auftauchen, inwieweit die thematische Verarbeitung die formalen Kriterien der gewählten Theorie erfüllt und in welcher Weise der Komponist die ihm durch die Regeln gegebenen Freiräume nutzt. Die Interpretation dieser Übereinstimmungen, Abweichungen und künstlerischen Ausgestaltungen hat sich im Laufe der Geschichte der musikwissenschaftlichen Analyse stark gewandelt. Alle Herangehensweisen sind dabei auch heute noch legitim, obwohl Vertreter anderer Methoden sie teilweise stark kritisieren.

Die strenge Interpretation sieht jede Abweichung von den reinen Kompositionsregeln als Unzulänglichkeit oder sogar Fehler des Komponisten an. Bei »fehlerfreier« Satztechnik steht die Beurteilung der künstlerischen Ausgestaltung der Freiräume im Vordergrund.

Die Ursprünge der strengen Interpretation gehen auf die bürgerlichen »Meisterwerk-Ästhetik« des 19. Jahrhunderts zurück. Damals begannen erstmals auch Nicht-Musiker, sich der eingehenden Analyse musikalischer Werke zu widmen. Wie auch bei der Musikerausbildung dienten die damaligen Kompositionslehren, deren Umsetzung in analytische Fragestellungen keiner Legitimation bedurfte, als Grundlage. Auch die konkreten (Meister-)Werke Beethovens und später auch Bachs dienten als Maßstäbe, an denen die nachfolgenden Kompositionen sich messen lassen mussten. Wichen sie ab, so wurden sie nicht ob ihrer Unterschiedlichkeit eingehender untersucht, sondern abqualifiziert.

Die inhaltsästhetische Interpretation unterscheidet sich von der strengen Interpretation dadurch, dass sie Abweichungen von der reinen Kompositionslehre nicht unbedingt als Fehler ansieht, sondern prüft, ob der Komponist mit diesem formalen Bruch zum Beispiel auf einen wie auch immer gearteten inhaltlichen Bruch hinweisen will. Am offensichtlichsten können solche Zusammenhänge bei Vokalwerken (zum Beispiel Kantaten, Oratorien, Opern und Liedern) hergestellt werden, die einen expliziten Inhalt haben. Bei Instrumentalwerken muss der Interpretationsrahmen weiter gefasst werden.

Grundlage der vergleichenden Analyse sind mehrere Einzelwerkanalysen. Ausgehend von einem Vergleich der darin identifizierten Themen können sowohl Ähnlichkeiten innerhalb von bestimmten Gruppen von Werken als auch Unterschiede zwischen Werkgruppen etabliert werden. Für die Menge der prinzipiell unbegrenzten Vergleichsmöglichkeiten können unter anderem die folgenden als Beispiele dienen:[5]

Beim komponistenspezifischen Vergleich stehen werkübergreifende Ähnlichkeiten im Vordergrund, die für einen bestimmten Komponisten typisch sind und somit als dessen Merkmale gelten können. Ein Komponist kann zum Beispiel ein Thema in nahezu identischer Form in mehreren Werken einsetzen oder aber ein Thema über mehrere Werke hinweg in weiterentwickelter Form wiederaufgreifen. Auch ohne Wiederverwendung eines bestimmten Themas können Themen zahlreiche strukturelle Parallelen aufweisen, die oft die Ursache des speziellen Klangs eines Komponisten ausmachen.

Dieses Vorgehen lässt sich auf epochenspezifische Vergleiche und länderspezifische Vergleiche ausdehnen, wobei es dementsprechend zum Beispiel darum geht, teilweise bis zur sechsten oder siebten Note identische Themen als zeitabhängige Modeerscheinung zu deuten oder bestimmte Melodien und Rhythmen als landestypisch zu identifizieren.

Ein besonderer Analysegegenstand ist die Untersuchung unveränderter Wiederverwendungen durch andere Komponisten. Offensichtliche Formen sind hierbei die Variation – zum Beispiel Brahms’ Variationen über ein Thema von J. Haydn (op. 56a) – oder die Parodie – zum Beispiel Debussys Bezug auf das Vorspiel von Wagners Tristan und Isolde in Golliwogg’s Cake Walk. Andere Formen der Wiederverwendung können entweder als bewusste Hommage gelten oder aber ein – bewusstes oder unbewusstes – Plagiat sein, das Rückschlüsse über die eventuell unterbewusste Auseinandersetzung mit Werken anderer Komponisten zulässt.[6]

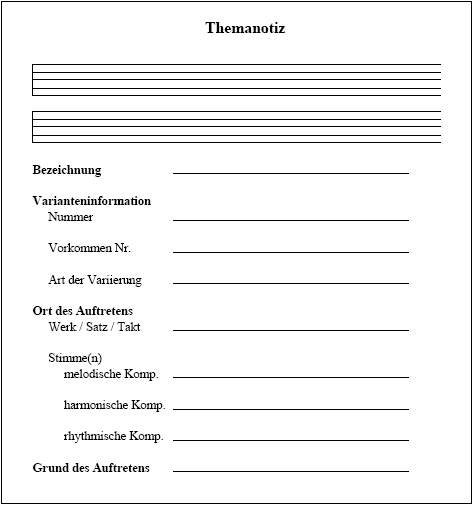

Abb. 6 Beispielhafter Notizzettel für die

manuell durchgeführte thematische Analyse.

Das Format und die Aufteilung der Einträge können von Analyse zu Analyse voneinander abweichen. Dieser Notizzettel mit seinen zwei Systemen von je 8 cm Länge und zwei Zeilen für Bezeichnungen stellt eine gute Ausgangsbasis für speziell angepasste Notizzettel dar. So ist es beispielsweise für komplexe Orchesterwerke vorteilhaft, weitere Systeme hinzuzufügen.

Ein Set ist eine aus bis zu 12 sich nicht wiederholender Pitch Classes[7] bestehende zusammenhängende Tongruppe, die im größeren Zusammenhang eines atonalen Musikstücks prägend wirkt. Gemäß Allen Fortes Set Theory[8] ist es für die strukturelle Bedeutung eines Sets unerheblich, in welcher Reihenfolge die Pitch Classes angeordnet sind, oder ob das Set transponiert oder umgekehrt wird. Dadurch reduziert Forte den Analysegegenstand der Set Theory von einer unüberschaubar großen Anzahl kombinatorisch möglicher Sets auf nur 224 Äquivalenzklassen von Sets, die er Set Classes nennt. Da aufgrund der vielfältigen Veränderungsmöglichkeiten nicht sämtliche Mitglieder einer Set Class unbedingt auf den ersten Blick erkennbar sind, kann in einem rein mathematischen Verfahren zu jedem Set dessen Prime Form ermittelt werden, die es mit allen anderen Mitgliedern der Set Class teilt. Um zur Identifikation von Set Classes nicht jedesmal die komplette Prime Form aufzählen zu müssen – immerhin bis zu 12 Pitch Classes – kann zu jeder der 224 Prime Forms eine Kurzbezeichnung aus einer Tabelle nachgeschlagen werden. Die Set Class mit der Prime Form 02479 hat zum Beispiel die Bezeichnung »5-35«, wobei »5« für die Länge und »35« für die laufende Nummer innerhalb der Gruppe derjenigen Set Classes steht, die fünf Pitch Classes lang sind.

Ein Set kann in einer beliebigen Gestalt in einem Werk auftauchen, solange es zusammenhängend ist. Dabei spielt es keine Rolle, ob die Pitch Classes eindimensional horizontal, eindimensional vertikal oder zweidimensional (also horizontal und vertikal verteilt) angeordnet sind.

Die Set Theory selbst macht keine Vorgaben, in welcher Form ein Werk aus Sets zu komponieren ist. Bezüglich der Auswahl der Sets wird aber gefordert, dass es im Werk möglichst genau eine ausgezeichnete Set Class mit der Bezeichnung Nexus Set geben soll, mit der alle anderen Set Classes des Stücks in abstrakter Form verbunden sind. Die zu diesem Zweck rein mathematisch definierten Relationen K und Kh (eher weiter beziehungsweise eher enger gefasste Form der Verbundenheit) beruhen ihrerseits auf einer weiteren Relation, die besagt, dass eine Set Class X als »abstrakt enthalten« in Y gilt, genau dann wenn mindestens ein Mitglied von X identisch mit der Prime Form von Y ist.

Wie auch bei der thematischen und leitmotivischen Analyse bildet sich ein klareres Bild von der Set-Theory-Analyse, wenn sie wie im Folgenden in einen musikhistorischen Kontext gestellt wird.

Nachdem Wagner in Tristan und Isolde aus dramatischen Gründen als erster Komponist im großen Umfang die Grenzen der strengen Tonalität überschreitet, beginnt eine Entwicklung zu tonaler Mehrdeutigkeit, die schließlich zu Beginn des 20. Jahrhunderts in völliger Bezugslosigkeit zu tonalen Zentren ihren Abschluss findet.[9] An Stelle der traditionellen Themen treten eine Vielzahl verschiedener Strukturelemente, die je nach Theoretiker beziehungsweise Komponist formal mehr oder weniger ähnlich wie Themen behandelt werden können. Die von Schönberg anfänglich verwendete Technik der Reihen aus 12 Pitch Classes wird im sich anschließenden allgemeinen Serialismus noch weiter gefasst, so dass Reihen nicht nur aus Pitch Classes, sondern aus allen musikalischen Parametern wie zum Beispiel Tondauern, Lautstärken, Oktavlagen oder Klangfarben gebildet werden können. Um den Behauptungen entgegenzutreten, die Vielzahl der neuen Kompositionstheorien bedeuteten den Verlust einer allgemein verbindlichen Tonsprache, entwickelt Allen Forte aufbauend auf Milton Babbits Arbeiten der 1950er Jahre die Set Theory, die mit Sets ein Strukturelement propagiert, das auf alle atonalen Kompositionen anwendbar ist.

Abb. 7 Mögliche Set-Segmentierung einer Passage aus

Igor Strawinskys Le Roi des Étoiles (Takt 42 bis 45)[10].

Die Sets sind gemäß der streng strukturellen Forte’schen Analyse bezeichnet. Die Nummer vor dem Bindestrich gibt die Kardinalität des Sets an, die Nummer danach die Reihenfolge innerhalb der Set-Gruppe gleicher Kardinalität. Sets können einander überlagern, so dass Sets großer Kardinalität teilweise Sets kleiner Kardinalität enthalten.

Der Set-Theory-Analyse geht es ebenso wie der thematischen Analyse um die Aufdeckung und Vermittlung struktureller und inhaltlicher musikalischer Zusammenhänge innerhalb eines Musikstücks. Insbesondere wird untersucht, welche Set Classes wo und in welcher Gestalt auftauchen, inwieweit deren Verwendung den theoretischen Kriterien der Set Theory genügt und in welcher Weise der Komponist die ihm durch die Theorie gegebenen erheblichen Freiräume nutzt. Der Grad der Anwendung der Set Theory ist dabei heftig umstritten, so dass das Analyseziel und -ergebnis stark davon abhängt, inwieweit den Forte’schen Vorschlägen gefolgt wird.[11]

Bei der streng strukturellen Forte’schen Analyse geht es darum, das Nexus Set einer Komposition zu finden. Dazu werden alle Sets identifiziert, deren Set Classes ermittelt und in Übereinstimmung mit Fortes Forderung das Nexus Set gesucht. Ein Analyseergebnis, das zu dem Schluss kommt, dass ein Werk mehr als ein Nexus Set enthält, lässt bei der strengen Analyse nur zwei Schlussfolgerungen zu: Entweder ist die Komposition einfach »weniger gut« oder der Analysator hat die Set Classes »falsch« identifiziert, so dass er das in Wirklichkeit vorhandene Nexus Set nicht finden konnte. »Weniger gute« Kompositionen können qualitativ noch abgestuft werden, indem die (möglichst kleine) Anzahl der weiteren Nexus Sets untersucht wird, die nötig sind, um all diejenigen Set Classes zu vereinen, die nicht im Haupt-Nexus-Set enthalten sind. Je dichter die Kardinalität des Nexus Sets an der Zahl 6 ist, desto aussagekräftiger und ergo besser ist die Komposition. Bei guten Kompositionen sind insbesondere die Art des musikalischen Hervortretens und die Artikulation der Set Classes von Interesse.

Alternative Analysen verwenden zwar das grundlegende Instrumentarium der Set Theory und größtenteils auch die Forte’schen 224 Set Classes, messen dem Nexus Set aber keine oder nur geringere Bedeutung zu. Zur Begründung wird angeführt, dass für die Sets teilweise entgegen den Segmentierungsrichtlinien Fortes abstruse Formen gewählt werden müssen, damit diese dann auf die »richtigen« Set Classes zurückführbar sind, die mit »dem« Nexus Set in Verbindung stehen. Die konkreten alternativen Analyseziele ergeben sich daraus, welche der ungefähr 40 vorgeschlagenen Theorien gewählt werden. Inhaltsästhetische Gesichtspunkte können dabei eine Rolle spielen.

Kompositionstreue Analysen setzen für Kompositionen, die nicht nach der Set Theory erstellt wurden, Sets und Set Classes nur als technisches Hilfsmittel ein, und greifen weder auf Fortes Einteilung der Set Classes noch auf dessen Ansichten zum Nexus-Set zurück. Statt dessen versuchen sie, Sets nur in dem Sinne zu interpretieren, wie es der Komponist des untersuchten Werks getan hat. Inhaltsästhetische Aspekte können – falls dies sinnvoll erscheint – mit einbezogen werden.

Ein Notizzettel für ein Set sieht dem für ein Thema recht ähnlich, wobei jedoch eine Unterteilung nach melodischer, harmonischer und rhythmischer Komponente irrelevant wäre. Außerdem könnte die Bezeichnung nicht frei gewählt werden, sondern ergäbe sich eindeutig dadurch, dass zunächst dessen Prime Form berechnet und anschließend der Name der dazugehörigen Set Class in der Set-Class-Tabelle nachgeschlagen wird.

Zum Ersten unterscheidet sich die Suche in Musik von Suche in herkömmlichen Texten grundlegend dadurch, dass das Material (Themen, Leitmotive, Sets) nicht in einer Standardform vorliegt, sondern unterschiedlichste Formen annehmen kann, die auf den ersten Blick nur sehr schwer als »Treffer« zu erkennen sind. Während eine Umkehrung eventuell noch sofort ins Auge fällt, so sind komplexe Umgestaltungen von Themen oder gar Sets nur sehr schwer zu erkennen. Ebenso wie in einem Text nach einer Zeichenkette zu suchen, ist also ein nahezu aussichtsloses Unterfangen.

Natürlich besteht auch bei der Textsuche die Möglichkeit, nicht nach einem feststehenden Begriff, sondern nach Varianten oder Bruchstücken zu suchen (Eine Suche nach »ein« kann beispielsweise verwendet werden, um »ein«, »mein« oder »einseitig« zu finden). Ein nützliches Hilfsmittel hierzu sind reguläre Ausdrücke, mit deren Hilfe komplexe Zeichenketten mit zahlreichen Flexibilitätspunkten spezifiziert werden können.[12] So können mit den Zeichen »^« und »$« beispielsweise der Wortbeginn oder das Wortende bezeichnet werden (»^ein« findet nur »ein« und »einseitig«). Mit Platzhaltern wie ».« und »*« können Zeichenfolgen unspezifiziert gelassen werden (».ein« findet »Wein« und »dein«, nicht aber »ein« oder »Rhein«; mit »*« können beliebig lange Zeichenfolgen ausgelassen werden). Weitere Sonderzeichen erlauben es unter anderem, die Platzhalter auf bestimmte Zeichen und/oder Zeichenfolgen bestimmter Länge einzuschränken. Eine Suche nach einigen verschiedenen Formen des Verbs »können« wäre unter anderem mit »(ge)k(a|e|o|ö)nn(en|e|st|t)« möglich. Dies würde allerdings auch Treffer für so unmögliche Formen wie »gekönnst« liefern. Um wirklich nur die gewünschten Treffer zu erhalten, müsste man entweder den Suchausdruck weitaus präziser gestalten oder im Endeffekt nach allen Formen separat suchen. Diese Variabiltätsanforderungen gelten auch für das Suchen in Musik.

Immerhin haben Suchtexte die Eigenschaft, nicht von der allgemeinen Textrichtung abzuweichen. Wie aber zu sehen ist, kommt bei Musik hinzu, dass es neben der zeitlichen Richtung auch ein »Oben« und »Unten« (Tonhöhe) gibt und dass von keiner dieser Richtungen davon ausgegangen werden kann, dass sie in Werk und Suchanfrage in gleicher Orientierung vorkommen.

Zum Zweiten gibt es neben den beiden erwähnten Richtungen in der Musik noch eine weitere Dimension: die der Gleichzeitigkeit. Wie aus den Notationsbeispielen ersichtlich wird, besteht musikalisches Material nicht nur aus einer einzigen Folge musikalischer Ereignisse, sondern aus mehreren parallelen Folgen. Themen und Leitmotive mit einer harmonischen Komponente können also nur dann gefunden werden, wenn das Material parallel durchsucht wird und die Treffer zeitlich synchron sind.

Texte können dementgegen für Suchzwecke als eine unendliche Zeile aufgefasst werden. Es spielt in aller Regel keine Rolle, ob ein Suchbegriff direkt über einem anderen Wort anzutreffen ist. Dass dieses Kriterium in der Regel keine Rolle spielt kann man auch daran sehen, dass es bei Neuauflagen durch die Wahl eines anderen Seitenlayouts zu einer stark abweichenden vertikalen Anordnung kommen kann, ohne dass dies Gegenstand gelehrten Protests wäre. Sofern es also nicht um Texte mit an bestimmten vertikalen Positionen versteckten Nachrichten oder um expressionistische Lyrik geht, kann man bei herkömmlichen Texten von eindimensionalen Suchgegenständen sprechen.

Drittens und endlich geht es bei der Suche in musikalischen Werken oft weniger um die Suche nach einer beliebig flexiblen Wiederkehr des gesuchten Materials, das sich um einen festen Kern rankt, der bereits im Suchbegriff enthalten ist (»knn« im Falle von »können«), sondern es wird viel mehr nach einer Abstraktion des Materials gesucht, die keinerlei Zeichen mit dem Original gemeinsam hat.

Die Möglichkeiten zur Bildung solcher Abstraktionen sind unbegrenzt und ein wichtiger Gegenstand musikwissenschaftlichen Forschens.[13] Eine Abstraktion muss lediglich das Kriterium erfüllen, unzweideutig aus musikalischem Material ableitbar und somit in einem wissenschaftlichen Diskurs verwendbar zu sein. Die folgende Aufstellung enthält am Beispiel des ersten Themas aus Ludwig van Beethovens Symphonie Nr. 6 acht gebräuchliche Abstraktionen des melodischen Bestandteils eines Themas.

Abb. 8 Die Melodische Komponente des ersten Themas aus Ludwig van Beethovens Symphonie Nr. 6 und acht verbreitete Abstraktionen.

Für die melodische Suche ist zum Beispiel weniger die absolute Tonfolge, sondern vielmehr die Folge von Halbtonintervallen interessant, obwohl sie keinerlei Zeichen mit der absoluten Tonfolge gemein hat. Doch gegenüber der absoluten Tonfolge hat die Folge von Halbtonintervallen den Vorteil, bezüglich Transponierungen invariant zu sein und so auch diejenigen Treffer zu finden, die zwar durch Zuhören, nicht aber durch symbolische Suche zu Tage treten.

Wenn ein Musikwissenschaftler ein Thema/Leitmotiv/Set sucht, dann sucht er nicht anhand einer exakten oder nur leicht modifizierten Wiederkehr »des« Materials, sondern er muss sich einer Kombination einer von ihm ausgewählten Kombinationen von – beispielsweise melodischen, harmonischen und rhythmischen – Abstraktionen des Materials bedienen, wobei im Gegensatz zur Textsuche mehrere Dimensionen berührt werden und zusätzlich gewisse Unschärfen zulässig sein müssen, um abgewandelte Formen des Materials finden zu können.

Bisweilen fällt es nur noch dann auf, wenn man E-Mails aus dem Ausland erhält: Die elektronische Repräsentation für Texte ist international weitestgehend standardisiert. Zumindest die akzentlosen Buchstaben und Zahlen sowie die wichtigsten Zeichen (Leerschritt, Interpunktion, et cetera.) werden weltweit einheitlich gemäß dem ASCII-Standard codiert. Lediglich regionale Sonderzeichen wie Umlaute und Akzente befinden sich in unterschiedlichen Ländern an unterschiedlichen Positionen, was in besagten E-Mails manchmal noch zu Tage tritt, wenn zum Beispiel an Stelle eines »Ä« ein merkwürdiges anderes Zeichen erscheint. Abgesehen davon lassen sich Texte jedoch weltweit austauschen, erzeugen und beschaffen und sind sofort mit den beschriebenen Textsuchverfahren behandelbar

Einen solchen Standard gibt es für Musikdaten nicht. Dies liegt im Wesentlichen daran, dass es für Musik keine »natürliche« Repräsentation gibt, die sich unmittelbar aufdrängt, wenn man darangehen will, Musik elektronisch zu codieren. Vielmehr lassen sich vier verschiedene Arten von Codierungen unterscheiden, die sich danach richten, welcher Aspekt der Musik festgehalten werden soll:[15]

Akustikdaten enthalten alle Informationen, um die Aufführung eines Werks möglichst originalgetreu wiederzugeben. Akustikdaten befinden sich auf mechanischen Tonträgern wie Schallplatten, Tonbändern und CDs In elektronischer Form liegen sie zum Beispiel als .mpg- oder wav.-Dateien vor.

Akustikdaten für ein und dasselbe Werk weichen naturgemäß von Aufnahme zu Aufnahme erheblich voneinander ab. Aufgrund des großen Interpretationsspielraums der ausführenden Künstler ist es unmöglich, anhand von Akustikdaten all diejenigen Informationen zu rekonstruieren, die in der zugrundeliegenden Partitur notiert sind. Außer für die Analyse von Aufführungspraxis spielen Akustikdaten nur als ergänzende Hilfe, nicht aber als Gegenstand musikwissenschaftlicher Analyse eine Rolle.

Synthesedaten dienen dazu, eine möglichst gute akustische Wiedergabe eines Werkes zu erzeugen, ohne sich einer tatsächlichen Aufnahme zu bedienen. Mechanische Formen dieser Datenart befinden sich auf den Lochpapierrollen für mechanische Klaviere und Orgeln oder auf den Walzen von Spieluhren. Das elektronische Äquivalent sind MIDI-Dateien. In diesen Dateien wird unter Bezugnahme auf eine Standardklaviatur festgehalten, welche Töne wie lange wie laut gespielt werden. Synthesedaten stellen gegenüber Akustikdaten einen Zugewinn an Konkretheit dar, bleiben aber weit hinter einer gedruckten Partitur zurück. So wird beispielsweise lediglich spezifiziert, dass die Taste zwischen C und D gehalten wird, nicht aber, ob es sich dabei um ein Cis oder ein Des handelt. Außer für die tonarteninvariante Set-Theory-Analyse ist diese Information aber unverzichtbar. Des Weiteren stellen die Synthesedaten ebenso wie Akustikdaten eine spezielle künstlerische Interpretation eines Werks dar, ohne dass sich die notierten Tempi oder Artikulationshinweise daraus ableiten ließen.

Notensatzdaten enthalten alle Informationen, um eine Partitur drucken zu können. Da Musikwissenschaftler sich meist auf die gedruckte Partitur beziehen, sind hier alle Informationen vorhanden, die für eine umfassende musikwissenschaftliche Analyse benötigt werden.

Allerdings sind auch Notensatzdaten keine ideale Grundlage für Analysen, da es sich primär um graphische und weniger um logische Informationen handelt. Das heißt, die Elemente der Partitur werden eher als graphische Objekte (»schwarzer Punkt mit Linie an Position (968,452«), denn als musikalische Elemente behandelt (»Viertelnote C, 3. Oktave auf dem zweiten Schlag im 4/4 Takt des 3. Takts für Oboe«). Zudem sind Notensatzdaten oft seitenorientiert organisiert, so dass es keinen Zusammenhang zwischen zwei logisch unmittelbar aufeinander folgenden Noten gibt, die durch einen Seitenumbruch getrennt sind.[16]

Analysedaten enthalten schließlich musikalische Daten in einer logischen Repräsentation, die weder durch Akustik, deren Synthese noch einer graphischen Wiedergabe untergeordnet ist.

Ebenso wie Textdaten können Akustik- und Notensatzdaten unmittelbar als Ergebnis bereits bestehender Prozesse genutzt werden. Abgesehen von rechtlichen Einschränkungen gibt es kaum einen Text, der nicht in elektronischer Form vorliegt. Ebenso sind für fast alle musikalischen Werke Akustikdaten verfügbar. Notensatzdaten gibt es zwar für einige, bei weitem aber nicht für alle Werke, da der elektronische Notensatz erst in den 1990er Jahren flächendeckend eingesetzt wurde. Während Analysen, die sich auf Texte, Tonaufnahmen und Notensatzdaten beziehen, also lediglich die ohnehin vorliegenden Daten nutzen können, so ist dies für Analysedaten nicht möglich, da es außerhalb der musikwissenschaftlichen Analyse keine Verwendung für sie gibt. Die Daten müssen daher entweder von Hand neu eingegeben[17] oder aus anderen Notensatzdaten aufwendig konvertiert werden – was durch den fehlenden Standard bei beiden Formatarten merklich erschwert wird.[18]

Ein sehr großer Teil musikwissenschaftlicher Untersuchungen wird nach wie vor mit »Einmaldatenformaten« durchgeführt. Diese Formate dienen einem speziellen Forschungszweck und werden nach Abschluss des Projekts nicht weiterverwendet.[19] Zu diesem Weg bestand früher keine Alternative. Aufgrund der geringeren Komplikationen waren diese Formate oft eindimensional (das heißt sie konnten harmonische Komponenten nicht berücksichtigen).

Generell einsetzbare Analyseformate müssen hingegen tabellenförmig – das heißt zweidimensional – sein, um den besonderen Eigenschaften von musikalischen Daten Rechnung zu tragen. Sie ahmen damit im Wesentlichen die Anordnung in einer Partitur nach, wobei die horizontale Dimension die zeitliche Sequenz einer Stimme darstellt, die vertikale Dimension die Konsonanz mehrerer Stimmen. Bei den »Einmaldatenformaten« wurden hier oft Tabellenkalkulations-programme verwendet.

Da Partituren meistens mehr Takte als Stimmen haben und sehr lange Zeilen schlecht edierbar sind, bedienen sich die beiden einzigen verbreiteten Musikdatenformate einer Form, bei der Tonfolgen von oben nach unten und Stimmen nebeneinander angeordnet werden:

Das 1994 von David Huron entwickelte Humdrum Toolkit[20] besteht aus einer Sammlung von über 40 Datenformaten und über 70 Werkzeugen, mit denen die Daten sowohl analytisch als auch zu Synthesezwecken bearbeitet und konvertiert werden können. Neben einem Kern-Format, das die wesentlichen in der Partitur notierten Elemente festhalten kann, gibt es für jede der bisher genannten Abstraktionen ein Spezialformat – zum Beispiel für Halbtonintervalle, Pitch Classes, Tonstufen, et cetera. Die musikalische Information wird tabellarisch gespeichert, wobei Zeilen Gleichzeitigkeit und spines genannte Spalten Zugehörigkeit zu einer logischen Sequenz – zum Beispiel einer Orchesterstimme – bedeutet. Die Art beziehungsweise das Format der Sequenz muss zu Beginn des Spines in einem mit »**« beginnenden exclusive interpretation record festgelegt werden (»**Tonh«), die abschnittsweise um beliebig viele, mit »*« beginnenden tandem interpretation records ergänzt werden kann (»*M4/4« für Viervierteltakt und »*Ivioln« für Violine). Eine Datei kann beliebig viele Spines besitzen, die durch Tabulator-Zeichen getrennt sein müssen.

!!!COM: Mildred and Patti Hill

!!!OTL: Happy Birthday

**kern **silbe exclusive interpretation records

*clefG2 * Violinschlüssel

*k[] * keine Tonartversetzungszeichen

*M4/4 * 4/4-Takt

*C: * C-Dur

!re A4=440Hz !(lyrics) Spine-lokale Kommentare

=1 =1 1. Takt

8.g/L Hap-

16g/Jk -py

4a/ birth-

4g/ -day

4cc\ to

=2 =2 2. Takt

2b\ you ;

8.g/L hap-

16g/Jk -py

4a/ birth-

=3 =3 3. Takt

4g/ -day

4dd\ to

2cc\ you ;

*- *-

Abb. 9 Happy Birthday als aus einem Kern- und einem

Silbe-Spine bestehende Humdrum-Datei.

Zu Beginn der Datei befinden sich die globalen Kommentare, die Auskunft über Komponisten und Titel geben. Danach teilt sich der Inhalt auf die zwei Spines in Kern und Silbe auf, die durch Taktstriche (»=«) gegliedert sind. Kern enthält zu jeder Note die Dauer in reziproker Notation (4 steht für eine Viertelnote), die Tonhöhe (wobei die Oktave durch die Anzahl der Tonbuchstaben kodiert ist) sowie zusätzlich rudimentäre Notensatzinformationen (zum Beispiel »/« Hals nach oben, »\« Hals nach unten, »L« Querbalkenanfang, »J« Querbalkenende).

Das zweite relevante Musikdatenformat ist das MuseData-Format. Es wird seit 1982 am Center for Computer Assisted Research in the Humanities zur Codierung von Daten für die weltgrößte Analysedatenbank eingesetzt[21]. Es ordnet die Daten ähnlich wie Kern tabellarisch an, wobei einige Spalten Layout- und andere Spalten analytischen Informationen vorbehalten sind. Da das MuseData jedoch außerhalb des CCARH nur wenig bekannt gemacht wurde, aber sehr viele Werke darin codiert sind,[22] wird es heute weniger zur direkten Analyse eingesetzt, sondern dient vielmehr als Übersetzungsgrundlage in Humdrums Kern-Format.

Obwohl es weiterhin zahlreiche Projekte gibt, die »Einmaldatenformate« verwenden, lässt sich in den letzten Jahren ein deutlicher Trend hin zu Humdrum ablesen. Das liegt vor allem daran, dass es Humdrum erlaubt, zusätzlich zu den 40 vorhanden Formaten weitere Spezialformate zu definieren, sofern diese den Grundregeln der Humdrum-Syntax genügen. Auf diese Weise kann Humdrum all diejenigen Musikwissenschaftler anziehen, die nicht »von null« beginnen wollen, die ihre Ziele in anderen »geschlossenen« Formaten nicht erreichen können.

Grundsätzlich stehen Musikwissenschaftlern, die mit Humdrum arbeiten, zunächst sämtliche Möglichkeiten zur Verfügung, die sich auch für eine normale Textsuche anbieten. Aufgrund der vertikalen zeitlichen Abfolge und der bereits erwähnten Abstraktionen ist dies aber – außer für Textrepräsentationen wie »**silbe« – nur selten ausreichend.

Als Hilfe bieten sich die über 40 Humdrum-Werkzeuge an. Es handelt sich dabei um kleine UNIX-Programme, von denen viele mit allen (strukturgleichen) Humdrum-Formaten arbeiten können. So ist es beispielsweise möglich, verschiedene Spines zu kombinieren oder bestimmte Abschnitte entweder nach Formatart (Pitch-Class-Informationen, Halbtonintervalle, et cetera) aus anderen Datentypen zu generieren oder aus bestehenden Daten nach vertikalen oder horizontalen Kriterien zu extrahieren.

Analytische Fragestellungen wie »Weisen Volkslieder einen melodischen Bogen auf?« können mit diesen Klein-Programmen gelöst werden, indem sie miteinander über sogenannte UNIX-»Pipes« verbunden werden. Das Ergebnis des vorangegangenen Programms wird damit unmittelbar zu den Eingabedaten des nächsten Programms in der Pipeline. Obwohl die Einzelprogramme jeweils nur eine sehr begrenzte Aufgabe erfüllen, können sie in Kombination sehr komplex werden. Um beispielsweise das Vorkommen einer bestimmten Melodie (das heißt Halbtonintervallfolge) zu einer in partitur.krn vorliegenden hinzuzufügen, ist die folgende Pipeline notwendig:

extract –i’**kern’ partitur.krn | semits -x | xdelta –s = | patt –t Melodie -s = -f Melodie.dat | extract –i’**patt’ | assemble partitur.krn

Wie komplex die Suche nach der Melodie gestaltet werden kann, hängt von dem verwendeten Humdrum-Programm ab:

Mit dem Kommando patt kann im Wesentlichen nach eindimensionalen regulären Ausdrücken gesucht werden, wobei das Suchmuster aufgrund der Anordnung der Spines im Gegensatz der zu Beginn geschilderten Textsuche vertikal statt horizontal ist. Um nach der melodischen Kontur »gleich, 2 aufwärts, 2 abwärts« zu suchen, müsste das Suchmuster wie folgt aussehen:

0

+2

-2

Das Kommando pattern lässt hochkomplexe Suchmuster zu. Die nachfolgende Sequenz findet eine Folge aus mindestens einem unmodifizierten G gefolgt von einem optionalem Gis gefolgt von mindestens einem Ton eines A-Dur-Dreiklangs, von denen der letzte das Ende einer Phrase darstellen muss:

[Gg]+[^#-] +

[Gg]+#[^#-] ?

([Aa]+|([Cc]+#)|[Ee]+)[^#-] *

(}.*([Aa]+|([Cc]+#)|[Ee]+)[^#-]))|(([Aa]+|([Cc]+#)|[Ee]+)[^#-].*})

Eine andere Art von Flexibilität kann mit dem Kommando simil erreicht werden. Es sucht nicht nach identischen Vorkommen, sondern misst die Edierdistanz zwischen Muster und Original.[23] Die Edierdistanz gibt die Anzahl von Schritten an, die notwendig sind, um einen Text mit Hilfe der Elementaroperationen »Einfügen«, »Löschen« und »Ersetzen« in einen anderen umzuformen. Den einzelnen Operationen können dabei unterschiedliche Gewichte zugeordnet werden. Je nach Distanz liefert simil zu jeder Spine-Position eine Liste von Nummern zwischen 0 und 1, wobei 0 keinerlei Ähnlichkeit und 1 vollkommene Übereinstimmung ausdrückt.

Mit in Humdrum vorliegenden Daten und den Humdrum-Werkzeugen steht eine Infrastruktur zur Verfügung, mit der prinzipiell alle bisher beschriebenen Suchen möglich sind. Das grundsätzliche Vorgehen wäre dabei wie folgt:

Sowohl Werk als auch Suchmaterial werden in die relevanten Abstraktionsformate transformiert (Halbtonintervalle, Pitch-Class-Folgen, Gesangstext, et cetera).

Je nach Suchanfrage wird jede dieser Abstraktionen mit einem dafür geeigneten Programm durchsucht (patt, pattern, simil). Beispielsweise wird die Halbtonfolgen-Repräsentation nach »gleich, 2 aufwärts, 2 abwärts« und der Gesangstext nach »Hap-py birth-day« durchsucht.

Als Gesamtresultat werden diejenigen Werkspositionen zurück-geliefert, die bezüglich aller Einzelergebnisse einen Treffer darstellen – das heißt, die eine Übereinstimmung bezüglich der Halbton-intervalle UND des Gesangstexts darstellen.

In der immer noch stark fragmentierten Welt der computergestützten musikwissenschaftlichen Analyse stellt Humdrum aufgrund seiner offenen Architektur sicherlich den aussichtsreichsten Weg zum Ziel der Standardisierung dar.[24] Humdrum hat jedoch zwei entscheidende Schwächen, wodurch die Mehrzahl der Musikwissenschaftler Humdrum niemals ernsthaft für ihre Analysen in Erwägung ziehen wird: Zum einen müssen alle Kommandos auf Kommandozeilenebene eingegeben werden. Zum anderen liegen alle Daten nur als Textdateien vor, ohne dass für den Musikwissenschaftler die Möglichkeit besteht, auf Grundlage des gewohnten Notensatzbildes zu arbeiten. Humdrums Benutzungsmodell entspricht damit frühen Betriebssystemen, die ohne graphische Benutzeroberflächen daherkamen, wie wir sie heute von Microsoft Windows oder Apple OS X her kennen. Nicht einmal die evolutionäre Zwischenstufe der textmodusbasierten Fensterdarstellung (wie sie beispielsweise frühere Textverarbeitungssysteme kannten) ist in Humdrum anzutreffen. Obwohl es zutreffend ist, dass die außerordentliche Flexibilität Humdrums schwerlich 1:1 in einem graphisch basierten System abzubilden wäre, so wäre es dennoch wünschenswert, wenn zumindest ein möglichst großer Teil der Humdrum-Funktionalität so zur Verfügung stünde, dass sie von dem größten Teil der musikwissenschaftlichen Gemeinde auch problemlos genutzt werden kann. Ohne eine graphische Benutzeroberfläche ist Humdrum trotz all seiner Möglichkeiten zu einem Nischendasein verdammt, da es nur von der sehr kleinen Untergruppe von Musikwissenschaftlern genutzt werden kann, die auch über solide Informatikkenntnisse verfügt.

Augenblicklich stehen zwei Systeme zur Verfügung, die Musikwissenschaftlern die Eingabe auf Kommandozeilenebene abnehmen wollen:

HumGUI[25] stellt das Äquivalent zu einer dateibasierten Komman-dozentrale wie beispielsweise dem Norton Commander dar. Auf der linken Seite wird eine Quelldatei ausgewählt, für die dann eine Pipeline aus Kommandos zusammengestellt werden kann. Das Ergebnis der Ausführung wird auf der rechten Seite angezeigt.

HumGUI stellt im Wesentlichen ein didaktisches Hilfsmittel zum Erlernen von Humdrum dar, da die Pipelines weiterhin von Hand zusammengestellt werden müssen. Durch die Gegenüberstellung von ursprünglichem Zustand und Resultat wird allerdings gut verdeutlicht, welche Auswirkungen eine bestimmte Kommandofolge hat. Die beiden Hauptschwachpunkte Humdrums (mandatorisches Informatikwissen und fehlende graphische Partiturdarstellung werden durch HumGUI allerdings nicht ausgeräumt.

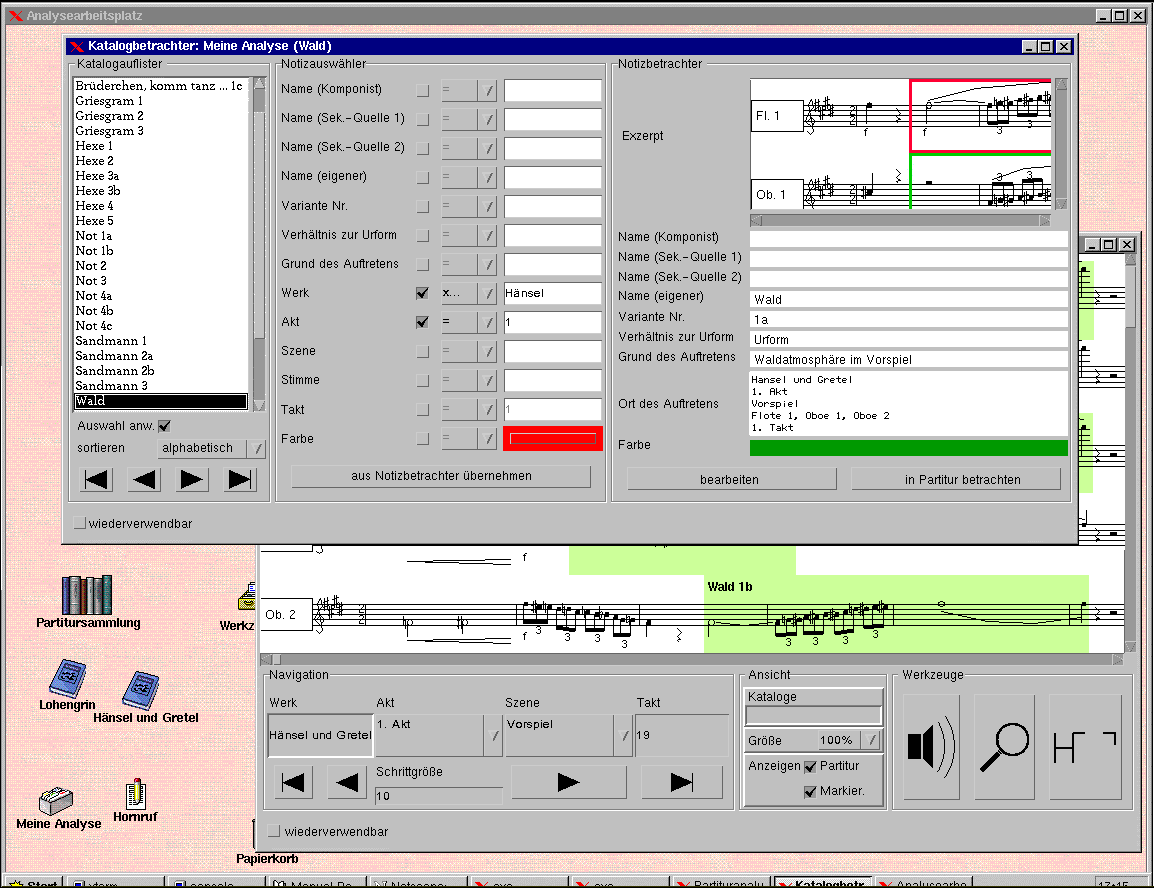

JRing[26] überwindet diese beiden Probleme, indem es eine vollständig graphische Benutzeroberfläche zur Verfügung stellt. Musikwissenschaftler können Partituren in druckgleicher Form betrachten und durch Mausaktionen bestimmte Materialien auswählen, suchen oder miteinander vergleichen. Für Suche und Vergleich können dabei alle zur Verfügungen stehenden Abstraktionen beliebig kombiniert werden. Humdrum wird komplett unter der graphischen Benutzeroberfläche verborgen. Da alle Materialen (Themen, Leitmotive, Sets, et cetera) intern als Humdrum-Dateien abgelegt werden, ist es dem informatisch bewanderten Musikwissenschaftler jederzeit möglich, die von ihm gesammelten Materialen mit Humdrums Spezialprogrammen weiterzubeabeiten.

Abb. 10 Das JRing-System

Während Humdrum und HumGUI bereits eine Weile zur Verfügung stehen, handelt es sich bei JRing um ein Forschungsprojekt, das erst 2005 auf den Markt gekommen ist. Es bleibt zu hoffen, dass es Musikwissenschaftlern mit den genannten und zukünftigen Werkzeugen möglich sein wird, ihre komplexen Suchen auf ähnlich komfortable Weise durchzuführen, wie es den meisten ihrer geisteswissenschaftlichen Kollegen mit herkömmlichen Texten schon seit Langem möglich ist.

Andreas Kornstädt (Quickborn)

Dr. Andreas Kornstädt

Feldbehnstraße 50b

25451 Quickborn

(05. August 2005)

Alphonce, Bo

1974 The Invariance Matrix, Dissertation (New Haven, CT: Yale University).

Barlow, Harold/Morgenstern, Sam

1948 A Dictionary of Musical Themes, xii (New York: Crown).

Blostein, Dorothea/Haken, Lippold

1993 The Tilia Music Representation: Extensibility, Abstraction, and Notation Contexts for the LIME Music Editor. In: Computer Music Journal 17/3, S. 43-58.

Carrell, Norman

1967 Bach the Borrower (London: George Allen & Unwin).

Castine, Peter

1994 Set Theory Objects: Abstractions for Computer-Aided Analysis and Composition of Serial and Atonal Music (Frankfurt: Peter Lang).

Cook, Nicholas

2004 Computational and Comparative Musicology. In: Eric Clark u.a. (Hg.): Empirical Musicology. Aims, Methods, Prospects. Oxford: Oxford University Press, S. 103-127.

Cope, David

1987 An Expert System for Computer-Assisted Music Composition. In: Computer Music Journal 11/4, S. 30-46.

Correia, Edmund Jr./Selfridge-Field, Eleanor

1997 Glossary. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 581-610.

Dydo, Stephen

1997 DARMS. The Note-Processor Dialect. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 175-191.

Eggebrecht, Hans Heinrich

1967 (Hg.): Riemann Musiklexikon, 950. Mainz: B. Schott’s Söhne.

Forte, Allen

1977 The Structure of Atonal Music. New Haven, CT: Yale University Press.

Friedl, Jeffrey E. F.

2002 Mastering Regular Expressions. Sebastopol, CA: O’Reilly and Associates.

Grabner, Hermann

1982 Allgemeine Musiklehre. Kassel: Bärenreiter.

Hewlett, Walter

1997 MuseData: Multipurpose Representation. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 402-447.

Huron, David/Orpen, Keith

1992 Measurement of Similarity in Music: A Quantitative Approach for Non-parametric Representations. In: Computers in Music Research 4, S. 1-44.

1994 The Humdrum Toolkit Reference Manual. Menlo Park, CA: CCARH.

Kornstädt, Andreas

1996 Formbildung durch Muster: Leitmotive und Objekte. I: Ein Werkzeug zur leitmotivischen Analyse von ›Der Ring des Nibelungen‹, Diplomarbeit. Hamburg, S. 67ff.

1998 CCARH’s Musical Databases on the Web: A Gold Mine for Musicologists. In: Proceedings of the XII Colloquium on Musical Informatics. Gorizia: Assoziazione di Informatica Musicale Italiana, S. 280-281.

2000 A Flexible Slide-In System for Computer-Assisted Musicological Analysis, Vortrag am Center for Computer Research in Music and Acoustic. Stanford: CCRMA, 13. 12. 2000.

2001a A Flexible Slide-In System for Computer-Assisted Musicological Analysis. In: Proceedings of the 5th World Multiconference on Systemics, Cybernetics and Informatics 10, S. 51-56.

2001b The JRing System for Computer-Assisted Musicological Analysis. In: Proceedings of the 2nd Annual International Symposium on Music Information Retrieval. Bloomington, IN.

Nettheim, Nigel

1998 Melodic Pattern-Detection Using MuSearch in Schubert’s »Die schöne Müllerin«. In: Computing in Musicology 11, S. 159-168.

Ó Maidín, Donncha

1992 Representation of Music Scores for Analysis. In: Alan Marsden/Anthony Pople (Hg.): Computer Representations and Models in Music. London: Academic Press, S. 67-93.

Selfridge-Field, Eleanor

1994 How Practical is Optical Music Recognition as an Input Method? In: Walter Hewlett/Eleanor Selfridge-Field (Hg.): Computing in Musicology. Menlo Park, CA: Center for Computer-Assisted Research in the Humanities, S. 159-166.

1997 Appendix 3: Code-Translation Programs. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 543-550.

1997 Introduction. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 3-38.

Smith, Leland

1997 SCORE. In: Eleanor Selfridge-Field (Hg.): Beyond MIDI: The Handbook of Musical Codes. Cambridge, MA: MIT Press, S. 252-280.

Solomon, Larry

1984 Music Analysis System Tuscon, AZ: Soft stuff.

Taylor, Michael

1996 Humdrum Graphical User Interface, MA Thesis. Belfast: Queen’s University.

| [1] | Vgl. Eggebrecht (1967: 950). |

| [2] | Vgl. Grabner (1982). |

| [3] | Vgl. Selfridge-Field (1998: 3-64, hier 8 ff.). |

| [4] | Vgl. Grabner (1982). |

| [5] | Vgl. Carrell (1967) und Cope (1987: 30-46). |

| [6] | Vgl. Barlow/Morgenstern (1948: xii). |

| [7] | Eine Pitch Class ist die Menge aller Töne, die oktavenunabhängig die gleiche Position in der 12stufigen chromatischen Tonleiter innehaben. Für jede der 12 Pitch Classes steht eine Zahl von 0 bis 11, wobei für 10 und 11 auch A und B geschrieben wird, um ohne zweiteilige Bezeichner auszukommen. |

| [8] | Vgl. Forte (1977). |

| [9] | Vgl. Grabner (1982). |

| [10] | Vgl. Forte (1977: 115). |

| [11] | Vgl. Castine (1994). |

| [12] | Vgl. Friedl (2002). |

| [13] | Siehe beispielsweise die Diskussion um die verschiedenen Arten von Set Classes. |

| [14] | In der Textrepräsentation sind die Zeichen wie folgt zu deuten. Absolute Tonfolge: die Ziffern bezeichnen die Oktave; - zeigt ein |

| [15] | Vgl. Kornstädt (1996: 67 ff.) und Selfridge-Field (1997: 3-38). |

| [16] | Vgl. Smith (1997: 252-280), Dydo (1997: 175-191) und Correia, Jr./Selfridge-Field (1997: 581-610, hier 585f.). |

| [17] | Im Gegensatz zu Texten ist es bei Partituren bisher noch nicht gelungen, Daten rasch durch Einscannen zu erhalten. Zwar gibt es mehrere Produkte, die die Musik einscannen, aber der Nachbearbeitungsaufwand ist so hoch, daß eine geübte Fachkraft die Daten ebenso schnell von Hand mit Hilfe eines Notensatzprogramms direkt eingeben könnte (vgl. Selfridge-Field (1994: 159-166)). |

| [18] | Vgl. Selfridge-Field (1997: 543-550, hier 547). |

| [19] | Beispielhaft hierfür sind Alphonce (1974); Solomon (1984), Ó Maidín (1992: 67-93), Blostein/Haken (1993: 43-58) und Nettheim (1998: 159-168). |

| [20] | Vgl. Huron (1994). |

| [21] | Vgl. Selfridge-Field (1997: 3-38, hier 34) und Hewlett (1997: 402-447, hier 450). |

| [22] | Vgl. Kornstädt (1998: 280-281). |

| [23] | Vgl. Huron/Orpen (1992: 1-44). |

| [24] | Vgl. Cook (2004: 103-127). |

| [25] | Vgl. Taylor (1996). |

| [26] | Vgl. Kornstädt (2000), Kornstädt (2001a: 51-56) und Kornstädt (2001b). |