1 Definitionen, methodische Grundlegungen und Einblicke in die Metrik-Theorie

»Automatisch« bedeutet, dass der Untersuchungsgegenstand – in diesem Fall ist es das in digitaler Form schriftlich niedergelegte deutschsprachige Gedicht – von einem Textzustand in einen anderen, detaillierteren Textzustand gebracht werden soll – und dass diese Zustandsveränderung derart von einem Rechner unterstützt wird, dass sie »per Knopfdruck« erreicht werden kann. Der Ausgangszustand ist in unserem Fall die digitale Kopie eines gedruckten Gedichtes in Form einer Textdatei, der Endzustand ein strukturiertes XML-Dokument mit metrischen Annotationen.

»Metrisch« bezieht sich zunächst auf die Tatsache, dass Wörter in Gedichten die Eigenschaft mitbringen, in betonte und unbetonte Silben aufgeschlüsselt werden zu können. Das ist eigentlich keine Eigenschaft von Gedichten allein, sondern die Eigenschaft eines jeden Textes, sei er gesprochen oder geschrieben. Ausgangspunkt dafür ist die Wortbetonung. Im Wort Garten, das aus zwei Silben besteht, liegt die Betonung zum Beispiel auf der ersten Silbe des Wortes – und zwar immer, egal ob in einem Gedicht oder in einem Gespräch über Rasenmäher. [1]

»Metrisch« meint aber auch, dass die Folge von »betonten« und »unbetonten« Silben über ein gesamtes Gedicht oder mindestens über eine Strophe des Gedichtes hinweg eine Regelmäßigkeit erreichen kann, die der Normalsprache fremd ist. Diese metrische Regelmäßigkeit führt zu einer Festlegung der Betonungsabfolge des verwendeten Wortmaterials.

Die Begriffe ›metrisch‹ beziehungsweise ›Metrik‹ beziehen wir daher im engeren Sinne nur auf Gedichte. Wenn in anderen (»normalsprachlichen«) Texten Gewichtungsanalyse betrieben wird, sprechen wir dagegen von ›Prosodie‹. [2] Wir unterscheiden dabei die Begriffe ›Hebung‹ und ›Senkung‹ im Kontext metrischer – und ›betonte‹ und ›unbetonte‹ Silben im Kontext prosodischer Gewichtungsanalysen, verwenden jedoch für beide Systeme die Zeichen + und –. [3]

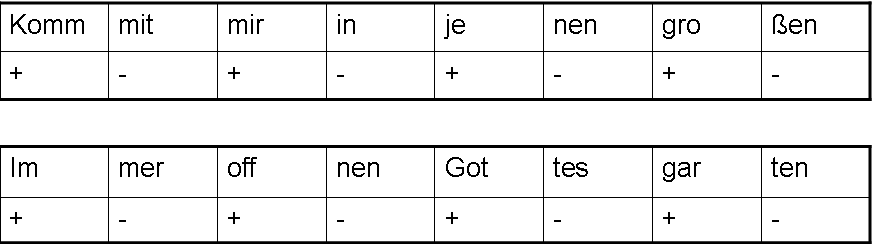

Das Wort »Garten« wäre metrisch betrachtet demnach » + – «. In Gedichten gehen auch einsilbige Wörter, die sich kontextlos nicht darin festlegen lassen, ob sie »gehoben« oder »gesenkt« sind, eine solche Festlegung ein. [siehe Abb. 1].

Abbildung 1: In Gedichten werden alle Silben entweder zu einer Hebung oder einer Senkung. Dadurch »versteifen« sich potentielle Gewichtungsmöglichkeiten eines Wortes, wie zum Beispiel im Wort mir, das in anderen Kontexten auch unbetont/gesenkt sein könnte. In Gedichten sind die Gewichtungsabfolgen der Silben oft regelmäßiger als in der Normalsprache (in diesem Beispiel alternierend).

Als ›Markup‹ verstehen wir die Informationsanreicherung digitaler Texte durch computerlesbare Annotationen. Diese Informationsanreicherung kann sehr vielfältig sein. Im Satz Ich gehe in den Garten könnte man zum Beispiel annotieren, dass es sich bei der Zeichenkette gehe um ein Verb in der 1. Pers. Singular Präsens handelt, dessen Grundform gehen ist: Das wäre grammatisches Markup. Metrisches Markup wäre demnach die Technik, metrische Informationen, also Informationen über die Abfolge von gehobenen und gesenkten Silben, in Form von Markup in einen digitalen Text einzuflechten. Automatisches metrisches Markup benennt die Technik, metrische Informationen derart in einen Text einzuarbeiten, dass der Rechner dabei alle notwendigen Schritte selbst ausführt. Hierzu gehört in erster Linie die Erkennung der Textstruktur und deren Umsetzung in ein Markup sowie die vollautomatische Auszeichnung entsprechender metrischer Werte [siehe Abb. 2].

Abbildung 2: Beispiel für strukturelles Markup und für die Annotation der Gewichtungswerte als Attribut des Elementes ›Silbe‹.

Im Falle eines Gedichtes müssen für die Erkennung der Textstruktur zunächst die Elemente ›Gedicht‹, ›Strophe‹, ›Vers‹, ›Wort‹ und ›Silbe‹ automatisch erkannt und annotiert werden, und dem Element ›Silbe‹ muss automatisch der Wert des Attributs »Gewichtungswert« zugewiesen werden können. [4] Markup, das mit Elementen und Attributen hantiert, basiert heutzutage zumeist auf XML. Für das menschliche Auge sind solche Strukturen, werden sie komplex, nicht mehr leicht zu interpretieren, aber Rechner können damit perfekt umgehen. XML ist in den digital humanities mittlerweile sehr weit verbreitet. Einen eigenen Standard zur Beschreibung geisteswissenschaftlicher Untersuchungsgegenstände auf XML-Basis formuliert die TEI (Text Encoding Initiative), die auch einen Standard für die Annotation von Gedichten bereitstellt. [5]

Die Frage ist nun: Wie könnte man das Ziel eines automatischen metrischen Markup erreichen?

Die Textstruktur eines Gedichtes zu erkennen fällt dem Rechner in den meisten Fällen sehr leicht, da digitale Gedichte im Text-Format folgende Eigenschaften mitbringen: Zwischen zwei Strophen befindet sich eine Leerzeile, die durch zwei aufeinander folgende feste Zeilenumbrüche definiert wird. Verse werden durch einen festen Zeilenumbruch voneinander getrennt, und die Grenze zwischen zwei Wörtern markiert ein Leerzeichen. Diese Informationen reichen aus, um die genannten Strukturen ›Strophe‹, ›Vers‹ und ›Wort‹ zu erkennen [siehe Abbildung 3].

Abbildung 3: Die eingeblendeten Steuerzeichen aus der Textverarbeitung zeigen, wie sich die Textstruktur eines Gedichtes automatisch bestimmen lässt. Gedicht zitiert nach [2].

Komplexer hingegen ist die Erkennung eines Gedichtes als maßgebliche Größe des Untersuchungsgegenstandes überhaupt. Folgen in einem digitalen Dokument zwei Gedichte aufeinander, so wird es oft schwierig, dem Rechner die Grenze zwischen diesen beiden Texten zu vermitteln.

Ein eher texttheoretisches Problem, das für die metrische Bestimmung von Gedichten jedoch äußerst wichtig ist, kann vielleicht mit folgender Frage am besten auf den Punkt gebracht werden kann: »If the Mona Lisa is in the Louvre, where [is] Hamlet?« Das Zitat geht wohl auf Frederick Wilse Bateson zurück. [6] In diesem Fall meint es: Wenn ein Gedicht metrisch annotiert wird, dann wird eigentlich nicht das Gedicht xyz annotiert, sondern nur eine Erscheinungsform des Gedichtes aus einer bestimmten Ausgabe – und nach der Annotation wäre es vorschnell zu behaupten, man wisse nun, welcher metrischen Struktur das Gedicht folge. [7]

Nur kurz gehen wir auf das Problem ein, wie es möglich sein kann, die Silbengrenzen innerhalb eines Wortes automatisch zu bestimmen. Will man hier Perfektion erreichen, so ist es wohl notwendig, mehrere Verfahren zu kombinieren. Getestet haben wir drei unterschiedliche Techniken: Eine orthographische Silbentrennung (Got-tes-gar-ten), eine quasi-prosodische Silbentrennung (Go-ttes-gar-ten) und eine technische Silbentrennung, die jede Silbe immer vor einer Vokalgruppe (die per definitionem aus einem oder mehrere Vokalen bestehen kann), – außer vor der ersten Vokalgruppe – trennt (Gott-esg-art-en). [8] Mittlerweile haben wir eine eigene Silbentrennung entworfen, die an die orthographische Silbentrennung angelehnt ist, jedoch noch nicht immer brauchbare Ergebnisse liefert. [9]

Nähern wir uns nun der Frage, wie es möglich sein könnte, den »Gewichtungswert« der einzelnen Silben zu bestimmen. Blickt man für die Beantwortung dieser Frage zunächst in Werke der Metrik-Theorie, so zeigt die Analyse eines Zitates aus Andreas Heuslers Versgeschichte besonders gut das Dilemma auf. Er schreibt: »Die Form der Versrede beschäftigt den Metriker. Und zwar die äußere Form, die hörbare Form, die Schallform.« [10] Und einige Seiten weiter: »Für den Metriker ist der Vers eine Gehörgröße. Das stille Lesen eines Gedichtes ist ihm so viel wie dem Musiker das Ablesen einer Partitur.« [11] Nimmt man diese Zitate ernst und sieht sie nicht nur als argumentative Notwendigkeit, Heuslers folgende Takt-Theorie zu begründen, dann geben sie einen niederschlagenden Hinweis: Es ist nicht Aufgabe der Metrik, die Frage nach den Gewichtungswerten einzelner Silben zu beantworten! Denn wenn der Metriker erst einer Verlautlichung des Textes bedarf, so ist die entscheidende Frage danach, wie zu verlauten sei, bereits beantwortet. Diese Annahme wird dadurch gestützt, dass in deutschen Metriken überhaupt nur spärliche Hinweise versammelt werden, nach welchen Regeln das grundlegende Handwerk des Metrikers zu erlernen sei und welche theoretischen Grundvoraussetzungen dabei gegeben sind. [12]

Da für unseren Ansatz der schriftlich fixierte Text Ausgangspunkt des automatischen metrischen Interpretation sein muss (und wir fest daran glauben, dass metrische Informationen bereits vor einer Verlautlichung in einem Text angelegt sind), bringt uns Heuslers Ansatz nicht weiter.

Dagegen führt Christian Wagenknecht in den Theoretischen Voraussetzungen seiner Deutschen Metrik eine Theorie zur Bestimmung von betonten und unbetonten Silben in schriftlich fixierten Texten ein, gibt aber bereits selbst an, dass es sich hierbei zunächst nur um »Faustregeln« handelt. [13] Die maßgebliche Bestimmung erfolge jedoch immer noch über das »Lexikon« [14] oder über die »syntagmatische Verbindung«. [15] Damit wird indirekt in die Prosodie verwiesen, aus der heraus sich die metrische Analyse speist.

Die früheste, uns bekannte Untersuchung zur deutschen Prosodie stammt von Karl Philipp Moritz, dem Autor des Anton Reiser. In seinem Versuch einer deutschen Prosodie von 1786 entwickelt Moritz erstmals Regeln der Prosodie, die er in Vorschläge für wohlgeformte Verskonstruktionen umsetzt:

Denn freilich fällt der Vers dann besser ins Ohr, wenn man bei der Silbenstellung auch mit auf die Buchstaben einige Rücksicht nimmt, und es so einzurichten sucht, daß eine Silbe mit einem Diphtong oder mehreren Konsonanten nicht zu oft als eine kurze Silbe neben einer andern steht, die sich nach der Anzahl und Beschaffenheit ihrer einzelnen Laute, leichter und in kürzerer Zeit aussprechen läßt [...] [16]

Daraus – und aus anderen Werken der Prosodie – lassen sich für uns etliche interessante Gesetzmäßigkeiten ableiten, die als Grundlage einer ›prosodischen Vorhersage‹ des Deutschen [17] dienen können.

Moritz selbst verknüpft am Ende seiner Ausführungen die Prosodie mit dem Feld der Grammatik:

[...] so muß derjenige, welcher in unsrer Sprache einen richtigen Vers machen will, wenigstens das Allgemeine der Grammatik und die Unterordnung der Redetheile nach ihrem prosodischen Gewicht verstehen. [18]

Neben den einschlägigen Metriken und den Ausführungen der Prosodie könnte also ein Blick in Grammatiken wichtige Hinweise zur prosodischen Vorhersage liefern. In den Handgrammatiken wird man jedoch zunächst nicht fündig. Die moderne Duden-Grammatik fasst diese Erkenntnisse äußerst sparsam auf zwei Seiten zusammen [19], verweist aber auf einige Literatur zu diesem Thema. Die Bertelsmann-Grammatik verzichtet – genau wie die Deutsche Grammatik von Helbig/Buscha [20] – gänzlich auf ein entsprechendes Kapitel. [21] Das Duden-Aussprachewörterbuch enthält im theoretischen Vorbau in den Kapiteln »Genormte Lautung« und »Deutsche Aussprachelehre« einige verwertbare Aussagen zur prosodischen Vorhersage. [22] Umfassendere grammatische Werke hingegen, wie die Grundrisse der deutschen Grammatik von Peter Eisenberg, liefern in den entsprechenden Kapiteln zwar etliche Hinweise. [23] Ein Gesamtkonzept lässt sich jedoch nicht ableiten.

Aber auch schon die Orthographie liefert einige interessante Hinweise für die Aussprache des Deutschen. So zeigt das Dehnungs-h bereits mit seiner Benennung an, dass durch seine Verwendung etwas (nämlich der vorausgehende Vokal) zu »dehnen« sei. Da die Vokallänge zumindest in einem mittelbaren Zusammenhang mit der Betonung steht, lassen sich aus allen orthographischen Anzeichen für Kürze und Länge auch Regeln für die Betonung ableiten.

Neuerdings finden sich vor allem im Kontext moderner linguistischer Untersuchungen zur »Generativen Metrik«, zur »Metrischen Phonologie«, zur »Text-To-Speech-Forschung« und zum »Natural Language Processing« etliche Ansätze zur regelhaften Beschreibung der Betonungsfolge. Leider merkt man diesen Untersuchungen stark an, dass sie ihren Ursprung in der angloamerikanischen Linguistik haben. Typisch deutsche Phänomene, wie zum Beispiel der Umlaut, werden dabei zu wenig berücksichtigt.

Alle diese Hinweise aus Metriken, Grammatiken und Aussprache-Wörterbüchern, durch orthographische Phänomene und linguistische Untersuchungen wurden für das Projekt Automatisches metrisches Markup gesammelt und in ein Regelwerk überführt, in dem definiert wurde, ob das Auftreten eines Phänomens Hinweise auf die Gewichtung einer Silbe innerhalb eines gedruckten deutschsprachigen Gedichtes geben kann. Dieses Regelwerk ist die Basis für die sogenannten »prosodischen Vorhersagen«. [24] Dazu war es notwendig, den Rechner mit diesen Regeln zu »füttern«, um im Anschluss daran zu prüfen, ob sich daraus für die Analyse eines Gedichtes Aussagen zur Metrik ableiten lassen, die in ein anschließendes metrisches Markup münden. Eine wichtige Eigenschaft unserer Regeldefinition besagt, dass Regeln lediglich Verdachtsmomente sind – sie können, müssen aber nicht zutreffen. [25] Die Wahrscheinlichkeit ihres Zutreffens muss allerdings größer sein als die Wahrscheinlichkeit, dass dem nicht so ist. [26]

2 Vorausgehende Forschung zum automatischen metrischen Markup

Der Versuch einer automatischen metrischen Analyse von Gedichten wurde auch schon von anderen unternommen, so zum Beispiel in den Arbeiten von Pablo Gervás. Der dort beschriebene Ansatz dürfte dem unseren sehr ähnlich sein:

Spanish does have a set of rules that allow automatic location of the stressed syllable of a word from its written form. This is important because it allows analysis with no need for a lexical entry for each word in the verse. [27]

Leider verweist diese Arbeit für die Erzeugung der prosodischen Vorhersage-Regeln auf eine spanischsprachige Publikation, welche von uns bislang nicht übersetzt werden konnte. [28] Da zudem jede Sprache ihre eigenen Problemstellungen mit sich bringt – zum einen durch besondere prosodische Problemstellungen, zum anderen aber auch aufgrund unterschiedlicher Grundverständnisse metrischer Ordnung – ist die Adaption einer landesspezifischen Technik kaum zu erreichen.

Für das Deutsche liegt eine ähnlich geartete Arbeit von Friedrich Michael Dimpel vor: Computergestützte textstatistische Untersuchungen an mittelhochdeutschen Texten. [29] Auch hier wird über prosodische Vorhersagen und euphonischen Regeln sowie statistischen Analogieverfahren eine metrische Bestimmung der Texte erreicht. Im Gegensatz zu dem von uns betriebenen Projekt arbeitet Dimpel jedoch sehr stark mit Wortlisten und ist, wie der Titel der Arbeit zeigt, auf das Mittelhochdeutsche beschränkt. Die Spezifika der Ausarbeitungen lassen eine Übertragung auf frühneuhochdeutsche und neuhochdeutsche Texte nicht zu. Die bei Dimpel erreichte Genauigkeit in der metrischen Bestimmung der Hebungen wird mit überzeugenden 97% angegeben. [30]

Eine weitere Arbeit für das Deutsche, YASP, ist leider nicht dokumentiert, der Internetauftritt des Projektes ist zudem neuerdings auch nicht mehr öffentlich zugänglich [31]. Die unveröffentlichte Diplomarbeit von Georg Niklfeld Modeling word stress of German aus dem Jahr 1996, auf die sich das Projekt maßgeblich bezieht, wurde uns freundlicher Weise zur Verfügung gestellt. Vor allem diese Diplomarbeit konnte uns einige gute Ansätze liefern.

Ebenfalls kaum dokumentiert sind die englischsprachigen Arbeiten von David J. Birnbaum. [32] Hier kommt erschwerend hinzu, dass die Beispiele allesamt aus dem Russischen stammen und sprachliche Probleme eine genaue Analyse des Vorgehens erschweren.

Auch wenn wir sicherlich noch nicht die gesamte Forschungslandschaft hierzu überblicken, so lässt sich zusammenfassend sagen, dass es bislang wohl noch nicht gelungen ist, eine Erkennungsquote von beinahe 100% zu erreichen. Viele Projekte sind eher als »Versuch« zu bewerten und gingen über einen Prototypen nicht hinaus. Keines der uns bekannten Projekte lässt sich on- oder offline testen.

3 Die Praxis

Nähern wir uns nun detaillierter der von uns angewendeten Technik zur automatischen metrischen Bestimmung – zunächst an einem Beispiel. Das Wort »blühen« besteht aus zwei Silben: blü|hen. Im Folgenden werden alle auf dieses Wort zutreffenden Regeln aufgeführt.

a) Eine der aufgestellten prosodischen Vorhersage-Regeln besagt, dass eine Silbe mit einem Umlaut (in diesem Fall ü) das Verdachtsmoment zulässt, dass es sich hierbei um eine betonte Silbe handelt. Geben wir dieser Silbe einen sogenannten »positiven Schlag«, um das festzuhalten.

b) Eine weitere Regel besagt, dass Silben dann das Verdachtsmoment zulassen, betont zu werden, wenn sie ein Dehnungs-h enthalten oder wenn die Folgesilbe mit einem h als Silben trennendes h beginnt. Die erste Silbe erhält noch einen positiven Schlag.

c) Eine andere Regel besagt, dass sogenannte »offene Silben«, das sind Silben, die auf einem Vokal enden, den gleichen Verdacht zulassen. Die erste Silbe erhält einen weiteren Schlag.

d) Eine weitere Regel besagt, dass Wörter, die mehr als eine Silbe aufweisen, statistisch betrachtet eher auf der ersten Silbe betont sind als auf einer der anderen. [33] Auch diese Regel trifft zu, da es sich bei dem Wort blühen um ein zweisilbiges Wort handelt. Die erste Silbe des Wortes erhält noch einen Schlag.

e) Und eine letzte Regel besagt, dass die Konsonantengruppe bl ebenfalls dieses Verdachtsmoment einer Betonung zulässt. [34] Die Silbe erhält ihren letzten Schlag.

Das Ergebnis ist Folgendes: Etliche Verdachtsmomente sind gegeben, die dafür sprechen, dass das Wort blühen auf der ersten Silbe betont wird. Kein Verdachtsmoment spricht dafür, dass das Wort auf der zweiten Silbe betont wird. Kein Verdachtsmoment allein wäre in der Lage, eine Behauptung über die Betonungsabfolge des Wortes aufzustellen, aus dem Zusammentreffen mehrerer Verdachtsmomente hingegen lassen sich stichhaltige Behauptungen ableiten [siehe Abbildung 4].

Abbildung 4: Alle fünf beispielhaft angewendeten Regeln produzieren ein Verdachtsmoment für die Betonung auf der ersten Silbe, dagegen ist kein Verdachtsmoment für die Betonung auf der zweiten Silbe gegeben.

3.1 Prosodie

Sehen wir uns die Anwendung aller Regeln [35] nun einmal für ein ganzes Gedicht [36] an:

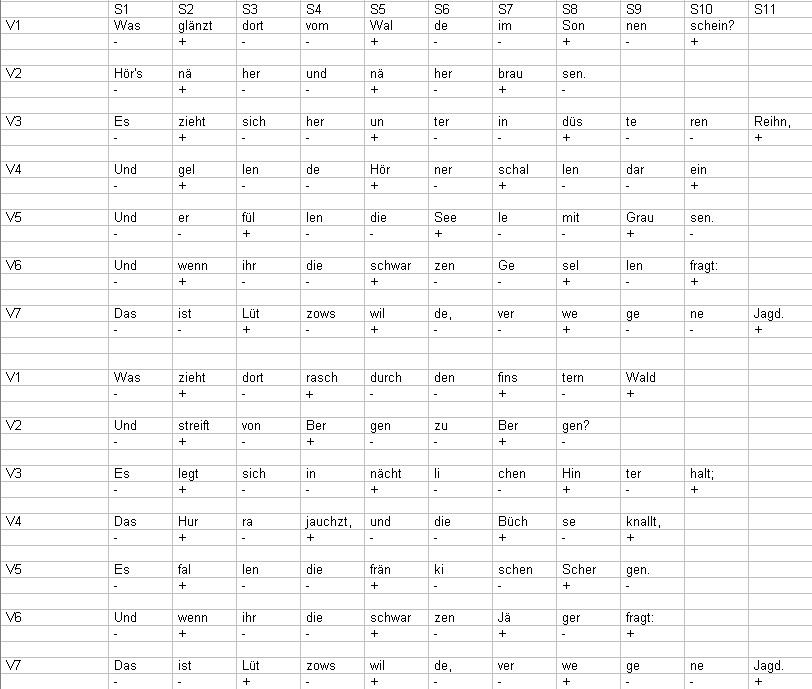

Abbildung 5: Die »Schläge«, die eine Silbe aus allen Regeln erhält, werden in einem Feld notiert. Das Wort »glänzt« in Vers 1, Silbe 2 hat demnach drei Schläge erhalten. Es werden hier nur Regeln notiert, die einen Schlag produzieren. Bei dieser Form der Abbildung ist nicht ersichtlich, aus welcher Regel ein »Schlag« stammt.

Wie zu ersehen ist, konnte durch die Anwendung aller prosodischen Vorhersagen eine erkleckliche Anzahl an Silben mit »Verdachtsmomenten« bestückt werden. Ein »x« steht hierbei für die foot form trochaic rule, der Regel der Erstsilbenbetonung mehrsilbiger Wörter. Ein »+« steht für einen beliebigen positiven Schlag aus einer anderen Regel (manche Regeln erzeugen auch einen Doppelschlag), ein »-« steht für einen Negativschlag – für das Verdachtsmoment also, dass es sich hierbei um eine unbetonte Silbe handeln könnte – und eine »0« steht für eine Silbe, die noch gar nicht qualifiziert werden konnte. Dass die erste Silbe eines Verses so gut wie nie mit Schlägen versehen ist, liegt an einer Zusatzregel, die etliche Regeln aufhebt, wenn sie auf die erste Silbe eines Verses fallen. [37] [siehe Abbildung 5].

3.2 Euphonie

Um das Verfahren nun noch zu verfeinern, werden im Anschluss an die prosodische Vorhersage Regeln der Euphonie angewendet. ›Euphonie‹ meint in unserem Zusammenhang den Wohlklang in der Abfolge von betonten und unbetonten Silben innerhalb eines Verses. Die beiden wichtigsten Regeln der Euphonie lauten: Es können nie zwei betonte Silben nebeneinander liegen, und es ist nicht erlaubt, dass drei unbetonte Silben nebeneinander liegen. Die beiden Regeln werden pro Vers betrachtet und immer von den Silben aus angewendet, die die meisten Verdachtsmomente innerhalb eines Verses tragen. [38] Durch die Anwendung der Regeln können demnach Silben, die aus den prosodischen Vorhersagen noch keine Verdachtsmomente aufweisen, mit Verdachtsmomenten angereichert werden. Ebenso ist es möglich, dass Silben mit weniger Verdachtsmomenten von Nachbar-Silben mit mehr Verdachtsmomenten »überstimmt« werden.

Vor allem sogenannte »antike Strophenformen« folgen den aufgestellten euphonischen Regeln allerdings nicht, da sie einen Hebungsprall [39] (stress clash) zulassen. Sie werden aufgrund ihrer vordefinierten Silbenzahlen pro Vers und Strophe zuvor technisch abgefangen und anders behandelt.

Das Ergebnis sieht folgendermaßen aus: Bis auf acht Silben liegen jetzt Informationen vor, wie die Reihenfolge von betonten und unbetonten Silben aussehen könnte. Durch die Anwendung der Euphonieregeln lassen sich vor allem solche Positionen definieren, die neben Silben liegen, die viele Verdachtsmomente für Betonungen aufweisen. Silben, die das Verdachtsmoment zulassen, dass es sich bei ihnen um eine unbetonte Silbe handelt, sind dagegen nur in Kombination in der Lage, benachbarte Positionen mit neuen Verdachtsmomenten zu belegen. Ein typischer Fall wäre die Kette »–|0|–«, in der nach den Regel der Euphonie 0 zu + wird, da sonst drei unbetonte Silben nebeneinander liegen würden [siehe Abbildung 6].

Abbildung 6: Anwendung der Euphonie-Regeln. Da gewisse Regeln stärker gewichtet sind als andere Regeln, wird zum Beispiel Silbe 4 in Vers 3 zu einer unbetonten Silbe, da der Schlag auf dieser Silbe schwächer gewichtet ist als der Schlag aus einer anderen Regel auf der Silbe 5.

3.3 Analogie

Um letztlich zu einer hundertprozentigen Bestimmung aller Silben zu kommen, wird im Anschluss an die Euphonie ein statistisches Analogieverfahren angewendet. Alle Silben, die noch nicht markiert werden konnten, werden anhand mehrerer Regeln zu bestimmen versucht. Dabei wird zum Beispiel geprüft, ob in der betreffenden Strophe in bereits ausdefinierten Versen die Anzahl der betonten Silben gleich ist. Ist dem so, dann wird zunächst versucht, das noch nicht bestimmte Silbenmaterial in den anderen Versen so zu konstruieren, dass es der Anzahl der betonten Silben der anderen Verse entspricht.

Nun werden noch unbestimmte Silben mit Silben anderer Verse auf der gleichen Position verglichen (also zum Beispiel Silben, die auf der fünften Position eines Verses liegen, werden mit Silben anderer Verse verglichen, die ebenfalls auf der fünften Position liegen). Dabei werden zuerst Silben in das Analogieverfahren übernommen, die aus der selben Strophe stammen, die gleiche Silbenanzahl pro Vers aufweisen und sich auf den Vers reimen, aus dem die noch nicht markierte Silbe stammt. [40] Entsteht eine Unschlüssigkeit, dann werden auch Silben aus Versen, die sich nicht reimen, oder Verse aus anderen Strophen in das Analogieverfahren eingebunden.

Das Ergebnis nach dem Analogieverfahren sieht wie folgt aus. Für alle Silben des Gedichtes liegen nun Verdachtsmomente vor [siehe Abbildung 7].

Abbildung 7: Die über das Analogieverfahren bestimmten Silben sind unterlegt. Die fünfte Silbe aus dem ersten Vers der zweiten Strophe wurde als »unbetont« bestimmt, weil sie wie die fünfte Silbe des vierten Verses der zweiten Strophe ist: Die beiden Verse haben gleich viele Silben, entstammen der selben Strophe und reimen sich aufeinander.

3.4 Metrik

Im folgenden Schritt werden die gesammelten »Verdachtsmomente« pro Silbe in Behauptungen überführt. Darunter verstehen wir den Wechsel von der Annahme, es könnte sich aufgrund von Verdachtsmomenten bei einer Silbe um eine betonte oder unbetonte Silbe handeln, – zu der Behauptung, es handle sich um eine Hebung oder Senkung. Die Zeichen + und – haben nun andere Qualität und sind jetzt metrische Werte. [siehe Abbildung 8].

Abbildung 8: Abschließendes metrisches Muster des Gedichtes. Nun sieht man, dass das Gedicht metrisch geformter ist als es der erste Blick vermuten ließ. Die Hebungsanzahlen pro Vers und Strophe sind festgelegt auf 4,3,4,4,3,4,4, die Senkungen sind frei verteilt, wobei jeder Vers mit einer Senkung eingeleitet wird.

Das Ergebnis ist erstaunlich. Alle Silben wurden »richtig« annotiert. Bisherige Tests zeigen, dass sich metrische Modelle von deutschsprachigen Gedichten im Durchschnitt zu einem Prozentsatz von 99% »richtig« erkennen lassen. [41] Selbst komplexe metrische Strukturen mit freien Hebungspositionen lassen sich so analysieren. Größte Probleme bereiten derzeit noch Fremdwörter (besser ›nicht-native Wörter‹), bestimmte Formen von Bestimmungskomposita und längere Ketten einsilbiger Wörter. Fremdwörter, weil sie oft anders konstruiert sind und anderen prosodischen Regeln folgen [42], und Bestimmungskomposita, da sie oft eine Betonungsverschiebung (stress shift) auslösen, deren Erkennung noch nicht in allen Fällen funktioniert. [43] Längere Ketten einsilbiger Partikeln führen immer wieder zu Problemen, da die wichtige Regel des Initialakzentes (foot form trochaic rule) nicht greift, die Menge der zutreffenden Regeln aus der prosodischen Vorhersage oft nur gering ausfällt und somit das Euphonieverfahren in diesen Textsegmenten nicht greifen kann. Nicht selten bleiben deshalb vor allem am Versbeginn Silbenpositionen bis zum Analogieverfahren unbestimmbar.

Das resultierende metrische Muster wird nun in TEI-kompatiblem XML abgespeichert. Das beinhaltet neben den strukturellen Analyseergebnissen wie ›Gedicht‹, ›Strophe‹, ›Vers‹, ›Wort‹ und ›Silbe‹ auch die Gewichtungswerte pro Silbe. Unklar ist derzeit noch die Frage, wie und ob es möglich sein wird, automatisches metrisches Markup auf Texte mit bereits erstellten XML-Strukturen anzuwenden, die womöglich schon über eine metrische Auszeichnung verfügen. Prinzipiell könnten dabei nicht-kohärente Strukturen und Annotationen entstehen, die natürlich vermieden werden müssen. [44]

4. Wozu das Ganze

Wozu das Ganze, sollte man sich immer fragen! Die hier vorgestellte Technik dient mehreren Herren. Zum einen lassen sich mit diesem Ansatz große Textkorpora automatisch annotieren, was ungeahnte Möglichkeiten in der metrischen Analyse von Texten erlauben würde. [45] Statistische Weiterverarbeitungen lassen sich in einer Vielzahl erdenken, ganz pragmatisch auch zum Selbstzweck der Verfeinerung des Regelsatzes. Hierfür wird es notwendig sein, statistisches Know-How in das Projekt einzubeziehen. Da das Programm lernfähig sein könnte, wäre es ebenso denkbar, eine Datenbank aufzubauen, in der alle Analyseergebnisse gespeichert werden, um sie zu unterschiedlichen Retrieval-Zwecken vorzubereiten. Prinzipiell wären dann auch Abfragen denkbar wie: »Gib mir alle mehr als zweisilbigen Wörter, die der Penultima-Regel, der foot-form-trochaic-Regel oder der weight-to-stress-Regel widersprechen«. Würde man das Konzept auf die prosodischen Vorhersagen minimieren, die euphonischen Regeln aufweichen und das Analogieverfahren ausblenden, wäre es auch denkbar, Prosatexte zu einem nicht unerheblichen Prozentsatz zu annotieren.

Auch in der Lyrik müsste es mit wenig Aufwand über die prosodischen Vorhersagen möglich sein, die von Wagenknecht aufgrund grammatischer Strukturen aufgestellten unterschiedlichen Schweregrade der Silben automatisch zu erzeugen, um so von der immer wieder als zu grob empfundenen zweiwertigen Metrik von Hebungen und Senkungen wegzukommen. [46]

Ein interessanter Aspekt hat sich in den bislang analysierten Beispielen noch gezeigt. Nicht selten werden in Gedichten die prosodischen Regeln der deutschen Sprache durch sogenannte Tonbeugung im Gedicht verletzt. Interessanterweise ist das hier beschriebene System in etlichen Fällen in der Lage, diese Verletzung der prosodischen Regeln zu erkennen. [47] Ebenso lässt sich in weiteren Fällen so etwas wie »Emphase« oder »kontrastive Betonung« erkennen, die durch den Zusammenfall von metrischer Struktur und Wortwahl entstehen kann. Auf das Wort so im letzten Vers des folgenden Beispiels würde nach den aufgestellten Regeln eigentlich eine Senkung fallen, da es wahrscheinlicher ist, dass auf muß eine Hebung liegt. Der Autor des Gedichtes [48] (Johann Wolfgang v. Goethe) verbindet aber das metrische Muster in der Form mit der Wortwahl des Textes, dass – glaubt man an die Regelmäßigkeit der metrischen Struktur des Gedichtes – Emphase auf dem Wort so erzeugt wird. Diese kann zunächst von dem Algorithmus nicht erkannt werden, wird aber in Folge eines Abgleichs des Analyseergebnisses mit regelmäßigen metrischen Mustern ableitbar [siehe Abbildung 9].

Abbildung 9: Dieses Beispiel zeigt das Analyseergebnis. Der letzte Vers wurde zunächst gegen das »vorherrschende Metrum« interpretiert. Das Ergebnis ist prosodisch vollkommen korrekt, metrisch aber eigentlich falsch, da es nicht dem »vorherrschenden Metrum« entspricht. Alle Analyseergebnisse werden deshalb am Ende noch einmal mit regelmäßigen metrischen Strukturen abgeglichen.

Zum anderen aber könnte man mit dieser Technik etwas erreichen, was bislang noch gar nicht möglich war: Computergenerierte Lyrik in vollkommener metrischer Harmonie, die in Verheiratung mit den Möglichkeiten der automatischen Textgenerierung unsere Vorstellung von Lyrik, Autorschaft und Urheberrecht auf den Kopf stellen könnte. Künstliche Intelligenz, in der das Wort künstlich eine Bedeutungserweiterung auf seine ursprüngliche Bedeutung von ›kunstvoll‹ erfahren würde – schöne Intelligenz! [49]

Das Interessanteste an dem Projekt ist jedoch, dass es etliche linguistischen Disziplinen verbindet und letztlich für jede Disziplin in der Lage ist, ein eigenes Ergebnis zu liefern. Sicherlich schlummern noch viele interessante Ideen zum Ausbau des Projektes in den Köpfen und Regalen der Universitäten. [50] Um davon zu profitieren, wollen wir möglichst bald den gesamten Regelsatz der prosodischen Vorhersagen [51] online stellen, damit ein Mitdenken möglich gemacht werden kann.

Die folgende Abbildung zeigt den Prototypen eines Java-Programms, das schon recht gut in der Lage ist, Textstrukturen zu erkennen und einige Regeln der Prosodievorhersage anzuwenden. [52] Auf der linken Seite wird ein Gedicht in das Programm hineinkopiert, auf der rechten Seite erscheint nach Auswahl der Analysefunktionen und Anklicken des »Analyse-Buttons« das Analyseergebnis. Die meisten »Regeln« warten aber noch auf eine technische Umsetzung [siehe Abbildung 10]. [53]

Abbildung 10: Ansicht des »Metricalizers«.

Alle Werte, die zwischen der Ansicht auf der linken Seite und der Ansicht auf der rechten Seite hinzugekommen sind, wurden automatisch erstellt.