Um die Angelegenheit noch zu verkomplizieren

- Geisteswissenschaften und Forschungsdaten im digitalen Kontext

Vor kurzem veröffentlichte die SCARP-Arbeitsgruppe des Data Curation Centers aus Edinburgh, die mit der Aufgabe betraut war, disziplinspezifische Unterschiede für den digitalen Umgang mit Forschungsdaten in den verschiedenen Wissenschaftsdisziplinen zu untersuchen, einen vorläufigen Abschlussbericht. [1] Dieser Bericht mit dem vielversprechenden Titel Data Dimensions ging hervor aus einer Reihe von sechzehn vorangegangenen case studies, bei denen der Umgang mit digitalen Daten in Forschungsprojekten aus den Bereichen Geisteswissenschaften, Empirische Sozialforschung, Medizin sowie Physik beobachtet und dokumentiert wurde. Der Abschlussbericht sollte dazu genutzt werden, die Ergebnisse zu systematisieren, um Aussagen über Stand und Perspektiven der digitalen Pflege und Verarbeitung von Forschungsdaten treffen zu können. Gleichzeitig ist dem Dokument jedoch auch eine Art verstecktes Ranking inhärent, welches die Wissenschaften entlang nur beiläufig erwähnter Kriterien ordnet – etwa der Standardisiertheit des Datenbestandes und eventueller Austauschprotokolle oder der größtmöglichen Zirkula-tion der Daten in der relevanten Wissenschaftsgemeinschaft. Nicht nur die von SCARP selbst bedauerte Tatsache, dass nur eines der sechzehn herangezogenen Projekte in den Geisteswissenschaften beheimatet ist und die Thematisierung der arts and humanities nicht mehr als eine von 36 Seiten füllt, verweist auf eine problematische Stellung der Geisteswissenschaften in dieser Studie. Die Erklärung, die für diesen Umstand herangezogen wird, ist zugleich unbefriedigend wie aussagekräftig. Sie mündet in der Feststellung eines unterschiedlichen »[...] cultural heritage of individual disciplines« [2]. Auch wenn im Folgenden dieses kulturelle Erbe nicht näher definiert wird, zeichnet sich im Verlauf des Textes doch ab, dass es dabei um das sozioökonomische Milieu geht, in dem eine Wissenschaftsdisziplin verankert ist. Faktoren, die geisteswissenschaftlichen Diskursen selbst entspringen, werden nicht angeführt. Es wird suggeriert, dass die Geisteswissenschaften dieses Erbe erst abstreifen müssten, um die Vorzüge gegenwärtigen digitalen Datenmanagements zu erfahren, von denen andere Disziplinen bereits profitieren. Davon abgesehen, dass dieser Subtext einen unproduktiven Gegensatz zwischen technikfernen und techniknahen Milieus aufmacht, verbaut er den Blick auf eine ganz entscheidende Data Dimension: das Verständnis davon, was Daten repräsentieren, was sie konstituiert und in der Folge, welche Rolle sie im Forschungsprozess überhaupt spielen können und sollen. Beide Punkte haben einen wissenschaftstheoretischen Hintergrund. Sie zielen sowohl auf die Semantik von Daten ab, also in welchem Verhältnis sie zu einem gegebenen Forschungsgegenstand stehen, als auch auf die Wissenschaftspraxis und die Frage, wie Wissenschaft zu Wissen gelangt. Dass dies auch ein möglicher Hintergrund für die eingangs formulierte Diagnose darstellen könnte, ist nur an einer Stelle des Berichts zu erahnen. So wird bei der Referenzierung der beiden Projekte Building Stories [3] und MACE[1], die sich um den Aufbau eines Datenbestandes im Bereich Architektur und Design bemühen, die Problemstellung überdeutlich:

To complicate matters further, it has been reported that conceptual design information – the nuanced, creative application of human knowledge – is by no means simple to capture in a form that can be adequately curated. [4]

Der Befund wird aber im Verlaufe des Textes nicht weiter systematisiert und bleibt isoliert. Forschungsdaten werden in der informationstechnologisch verankerten Diskussion um Data Curation zumeist nur dann als solche wahrgenommen, wenn sie, als quantifizierbare Fakten behandelt [5], standardisiert werden können. Damit wird eine positivistische Position eingenommen, deren Fragwürdigkeit für einige Wissenschaftsdisziplinen, die es mit symbolischen oder ästhetischen Ordnungen zu tun haben, unübersehbar ist. Am intensivsten ist diese Problematik im Spannungsfeld zwischen quantitativen und qualitativen Sozialwissenschaften behandelt worden [6]. Die Konfliktlinien, die entlang der Konstruiertheit von Datenmodellen und der Interpretierbarkeit von Daten verlaufen, sind für die geisteswissenschaftliche Forschung von großer Tragweite [7]. Vor diesem Hintergrund können und müssen die Geisteswissenschaften stärker kommunizieren, in welcher Form Forschungsdaten für sie eine Rolle spielen und vor allem, wie Forschungsdaten im Forschungsprozess verankert sind. Hieraus ließen sich Profile geisteswissenschaftlicher Datenbanken generieren [8], die zu einer besseren Nutzung von Datenbanken in den Geisteswissenschaften führen könnten und für mehr Transparenz gegenüber der Data Curation Community sorgen würden.

Der vorliegende Beitrag möchte sich an einer derartigen Klärung versuchen. Den Ausgangspunkt bildet das konkrete Beispiel des Personendaten-Repositorium (im Folgenden PDR genannt) für Personen des 19. Jahrhunderts, das zurzeit von der Deutschen Forschungsgemeinschaft finanziert und an der Berlin-Brandenburgischen Akademie der Wissenschaften(im Folgenden BBAW genannt) entwickelt wird. Die Datenbasis für das PDR stammt aus einem uneinheitlichen Forschungsmilieu und reflektiert gerade deshalb spezifische Probleme von Daten in den Geisteswissenschaften. Das Datenmodell der Infrastruktur, in das die Daten integriert werden sollen, darf darum einer zu formulierenden Forschungsfrage nicht vorhergreifen. In einer inhaltlich breit gefächerten und kollaborativen Forschungssituation an der BBAW müssen die Daten für viele Kontexte verwendbar bleiben.

Erzählte Identitäten – Das Personendaten-Repositorium

der Berlin-Brandenburgischen Akademie der Wissenschaften

Auch wenn der Projekttitel Personendaten-Repositorium suggeriert, es würde sich um eine klar bestimmbare Art von Daten handeln, muss diesem ersten Eindruck von vornherein widersprochen werden. Die Bedarfsanalyse, bei der die Daten, ihre Struktur, sowie ihre Verwendung im Forschungsprozess in den verschiedenen Vorhaben untersucht wurde, machte schnell klar, dass jedes Projekt in Abhängigkeit von seinem Forschungsfeld und seiner Auffassung von Personendaten eigene Ansätze entwickelt hatte.

Die auffälligsten und nächstliegendsten Unterschiede waren in der Form anzutreffen, in der die Daten gesammelt wurden. Die Spannbreite reichte von registerartigen Word-Dateien über MySQL-Datenbanken bis hin zu mehrfach gekapselten XML-Dokumenten. Neben dem Zeitfaktor, der mit Sicherheit mitentscheidend für die Wahl einer bestimmten Lösung war, reflektieren diese unterschiedlichen Vorgehensweisen aber auch verschiedene Auffassungen von Personendaten. So vermitteln Register den Eindruck eines klar identifizierbaren Objektes. Dieses erscheint im Personenregister als Name innerhalb einer vorgängigen – in der Abbildung alphabetischen – Ordnung mit eindeutigen Eigenschaften. Register repräsentieren damit eine bürokratische Sichtweise auf Personen. In der erwähnten XML-Lösung, die von Preußen als Kulturstaat (im Folgenden PaK genannt) auf der Basis des von TELOTA entwickelten Archiveditors[4] benutzt wird, werden die Personendaten hingegen nicht zusammen mit der Person, sondern zusammen mit der Quelle gespeichert, aus der sie stammen. Die Person wird lediglich referenziert. Dieser Ansatz problematisiert bereits die in den Registern formulierte Eindeutigkeit von Personendaten und unterstreicht ihre Abhängigkeit von rezipierenden Autoritäten. Schließlich können unterschiedliche Quellen sich widersprechende Angaben zu einer Person machen. Auch unterstreicht dieser Ansatz die Wichtigkeit nicht nur des Inhalts, sondern auch der Form der Daten für die Forschung, in diesem Fall die konkrete Formulierung in der Quelle. Die MySQL-Datenbanken der Berliner Klassik (im Folgenden BK) hingegen sensibilisieren gegenüber dem Problem der eindeutigen Identifizierbarkeit von Personen, indem in einer eigenen, von den restlichen Lebensdaten getrennten Tabelle Namensvariationen behandelt werden [9]. Dadurch wird für den Namen gegenüber anderen Personendaten eine gesonderte Bedeutung und Problemstellung konstatiert.

Ein Blick auf die Inhalte der Datenbanken lässt zudem deutlich werden, dass je nach Forschungsthema ganz unterschiedliche Daten aufgenommen oder dieselben Daten unterschiedlich semantisch erschlossen wurden. Für das Autoren- und Personenverzeichnis Alexander von Humboldt Bibliographie etwa steht die textuelle Produktion und Erfassung der Personen im Vordergrund, während die BK ein sehr differenziertes und eigenständiges Erschließungsrepertoire für die Präsenz und Aktivität der aufgenommenen Personen in Berlin entwickelt hat. Dafür reduziert sich der berufliche Werdegang auf eine allgemeine zeitlose Angabe, wie zum Beispiel »Philosoph«. PaK hingegen arbeitet mit einem differenzierten Unterscheidung zwischen Ausbildung, Beruf und Laufbahn. Darüber hinaus wird die perspektivische Bedingtheit von Klassifikationen dadurch unterstrichen, dass das System die Erweiterung von Klassifikationen zulässt, sobald die zunächst vorgegebenen nicht mehr ausreichen.

Dieser kurze und unvollständige Einblick in den unterschiedlichen Umgang mit Personendaten an der BBAW eröffnet zwei Problemfelder:

1. Personendaten entspringen einer diskursiven Umgebung, ihre Interpretation ist daher kontextabhängig. Ein angemessenes Verständnis der Daten setzt die Kenntnis dieser Kontexte voraus.

2. Die Struktur und die Menge von Forschungsdaten über Personen sind so divers wie die Quellen, denen sie entstammen. Sie lassen sich daher auch projektspezifisch nicht sinnvoll im Vorfeld begrenzen.

Welche Rückschlüsse lassen diese Beobachtungen nun auf den geisteswissenschaftlichen Forschungsgegenstand ›Person‹ zu und wie sieht die sich daran anschließende Forschungspraxis aus? Die Beantwortung dieser Fragen ist eine Bedingung für den Entwurf eines geeigneten Datenmodells. Ein erster Anhaltspunkt ist die Beobachtung, dass wir es mit einem nur unzureichend empirisch erfassbaren Gegenstand zu tun haben. Der Mensch, der gelebt hat, ist nicht identisch mit der Person, über die wir sprechen und die als Objekt in die Forschung tritt. Nirgends wird deutlicher als in den Normierungsversuchen des 19. Jahrhunderts, dass die Person eine soziokulturelle Kategorie ist, gewissermaßen das Kondensat, das ein Mensch in der gesellschaftlich-symbolischen Sphäre hinterlässt. Person und Mensch als identisch zu betrachten, würde mit den Worten Bourdieus bedeuten, Normalität, also den Bereich von Konventionen, mit dem konkreten Individuum zu verwechseln [10]. Letzteres befindet sich in ständiger Bewegung und Veränderung. Der daraus entstehenden Kontingenz des Lebens wurde versucht, mit Strategien der Identifizierung zu begegnen, indem man bestimmte Merkmale normierte und zu bürgerlichen Primärdaten machte. Der Aufwand, der vonnöten war, um die Konsistenz dieser Daten herzustellen, und der noch heute mancher Behörde anzumerken ist, zeugt jedoch von der Unüberwindbarkeit dieser Spannung.

Eine neue Dimension bekommt dieses Problem dadurch, dass beim biographischen Arbeiten Daten nicht isoliert, sondern in einem größeren Zusammenhang mit anderen Daten präsentiert werden. Personendaten in den Wissenschaften gehen über die bloßen Primärdaten zur Identifikation eines Menschen deutlich hinaus und folgen einer konkreten Forschungsfrage. Aus dem Kontext der Selbst-Philosophie veranschaulicht der Ansatz Daniel Huttos, wie ein Arbeiten mit Inhalten verstanden werden kann. Das Organisieren biographischer Aspekte zu zusammenhängenden Gebilden beschreibt er als eine Ästhetisierung und Fiktionalisierung unseres wirklichen Lebens in Narrationen [11]. Das bedeutet, dass Menschen aus dem unerschöpflichen Material ihres Lebens Sinnzusammenhänge im Modus und nach den Gesetzmäßigkeiten des Geschichtenerzählens formen. Diese Perspektive wird ebenfalls von der modernen Biographieforschung aufgenommen, so z.B. bei Griese und Griesehop, die Biographien als narrative Identitäten bezeichnen [12]. Ordnung entsteht durch die Bestimmung des Anfangs- und Endpunktes der Geschichte, durch das Berücksichtigen und unberücksichtigt Lassen von Lebensaspekten, durch die Art der Gruppierung und durch die Wortwahl, in der die Personendaten festgehalten werden. Biographisches Arbeiten ist also ein konstruierender Prozess, der aus der Mannigfaltigkeit an vorhandenen Informationen und Daten schöpft.

Welche Anforderungen folgen nun aus diesen Beobachtungen in Bezug auf ein Daten- und Inhaltsmodell für Personendaten in einem bio-graphischen Forschungszusammenhang im PDR? Wenn die Erzeugung biographischer Narrationen ein Prozess ist, der der Erhebung der Daten nachgestellt ist und der zudem vom semantischen Reichtum der Daten und nicht von seiner formalen Strenge abhängig ist, dann muss die Diversität der Ausgangsdaten im PDR erhalten bleiben. Da diese Diversität aber nur dann angemessen interpretierbar ist und beim Zugriff auf die Daten systematisiert werden kann, wenn ihr Entstehungshintergrund transparent ist, muss dieser in das Datenmodell integrierbar sein. Als eine Infrastruktur, die Teil aktiver Forschung sein wird, darf es keiner semantischen Erschließung der Daten vorausgreifen, sondern muss im Gegenteil erweiterbar bleiben. Zu guter Letzt muss das Datenmodell die Voraussetzungen für einen skalierbaren Zugriff auf die Daten durch den Benutzer bieten, da ihre Heterogenität sie in manchen Situationen nutzlos machen könnte.

Die genannten Anforderungen bringen in Bezug auf herkömmliche Vorgaben der Datenmodellierung einige wichtige Veränderungen mit sich. So meint Simsion: »Frequently, problems with data quality can be traced to a lack of consistency in (a) defining and interpreting data, and (b) implementing mechanisms to enforce the definitions« [13], und gibt das Beispiel der wechselnden Verwendung der europäischen und der amerikanischen Schreibweise des Datums. Was aus der Perspektive der Informatik inkonsistent erscheint, ist im vorliegenden Fall von großer Wichtigkeit. So lässt der Gebrauch eines spezifischen Formats Rückschlüsse auf das beschriebene Datenobjekt zu, zum Beispiel in welchen Regionen es erstellt wurde. Ähnlich verhält es sich mit der Vorgabe, Redundanz zu vermeiden und eine spezifische Information nicht an zwei verschiedenen Stellen abzulegen [14]. Wir haben gesehen, dass es für die biographische Erschließung von entscheidender Bedeutung sein kann, in welchem Kontext eine Information steht. Zwei Informationen mit demselben Informationsgehalt sind daher als unterschiedliche Daten zu betrachten. Die Konsistenz des Datenmodells bleibt zwar ein wichtiger Faktor, der Begriff der Konsistenz muss jedoch sehr viel offener ausgelegt werden. Nur so kann das PDR eine positive Antwort auf die Frage geben, die nach Simsion den Ausschlag für ein gelungenes Datenmodell gibt: »How effective is the model in supporting communication among the various stakeholders in the design of a system?« [15].

Anregungen für ein Datenmodell, das den genannten Anforderungen gerecht wird, ergeben sich aus Ansätzen, die sich mit der Modellierung heterogener Datenbestände beschäftigen, da diese mit vergleichbaren Problemen bezüglich unterschiedlicher Semantiken zu tun haben. Dabei kommen Strategien wie das Mapping oder Merging der Daten [16], die ihre Homogenisierung anstreben, für das PDR nicht in Frage. Als interessant stellt sich der Ansatz dar, den John McAuley und James Carswell beschreiben [17]. In ihrem Versuch, aus verschiedenen Quellen stammende Datensätze, die kulturelle Objekte beschreiben, zu integrieren, betonen sie ebenfalls die Rolle, die das Wissen um den Kontext für die Interpretation der Daten spielt. Ihre Lösung ist ein Datenmodell, in dem die Ausgangsdaten mit kontextuellen Metadaten angereichert werden können. Die Integration der Daten findet auf der Ebene der Kontextualisierung statt. Dies ermöglicht es, die Ausgangsdaten weitgehend unangetastet zu lassen. Für die Kontextualisierung wird mit CIDOC CRM [6] jedoch wieder ein Standard verwendet. Im PDR soll die Anreicherung der Daten mit kontextuellen Metadaten die Integration jedoch lediglich vorbereiten und nicht vollziehen. Die Kontexte müssen in der Perspektive und unter Verwendung einer Sprache verfasst werden, wie sie die Vorhaben, die die Daten erstellt haben, benutzen. Ansonsten würde sich die Bedeutung der Daten verändern. Tatsächlich ist es ja gerade das Ziel des PDR, den Benutzer in die Lage zu versetzen, über die semantische Integration der Daten selbst zu entscheiden, da nur er dazu in der Lage ist, die für ihn relevante Interpretationsleistung zu erbringen. So können z.B. die in der Quelle verwendeten Entity-Typen als Metadaten festgehalten werden. Unser Ansatz folgt damit einer Methode, die in der Datenmodellierung Pragmatic Data Integration genannt wird und die den Integrationsprozess in den Abfrageprozess verlagert [18]. Dies bedeutet, dass der Benutzer in seiner Anfrage darüber entscheidet, wie die Daten gemappt werden. Diese kann nur dann erfolgreich durchgeführt werden, wenn beachtet wird, was Andrew Branson in einem ähnlichen Zusammenhang unterstreicht: »The approach (...) relies on a separation of encoded information into data, metadata and semantics« [19]. Während sich die Trennung von Semantik und Metadaten durch die Pragmatic Data Integration Methode automatisch ergibt, ist es Aufgabe des verwendeten Datenmodells, die Trennung zwischen Daten und Metadaten sicherzustellen. Hierzu soll auf das vom PDR konzipierte Datenmodell etwas konkreter eingegangen werden.

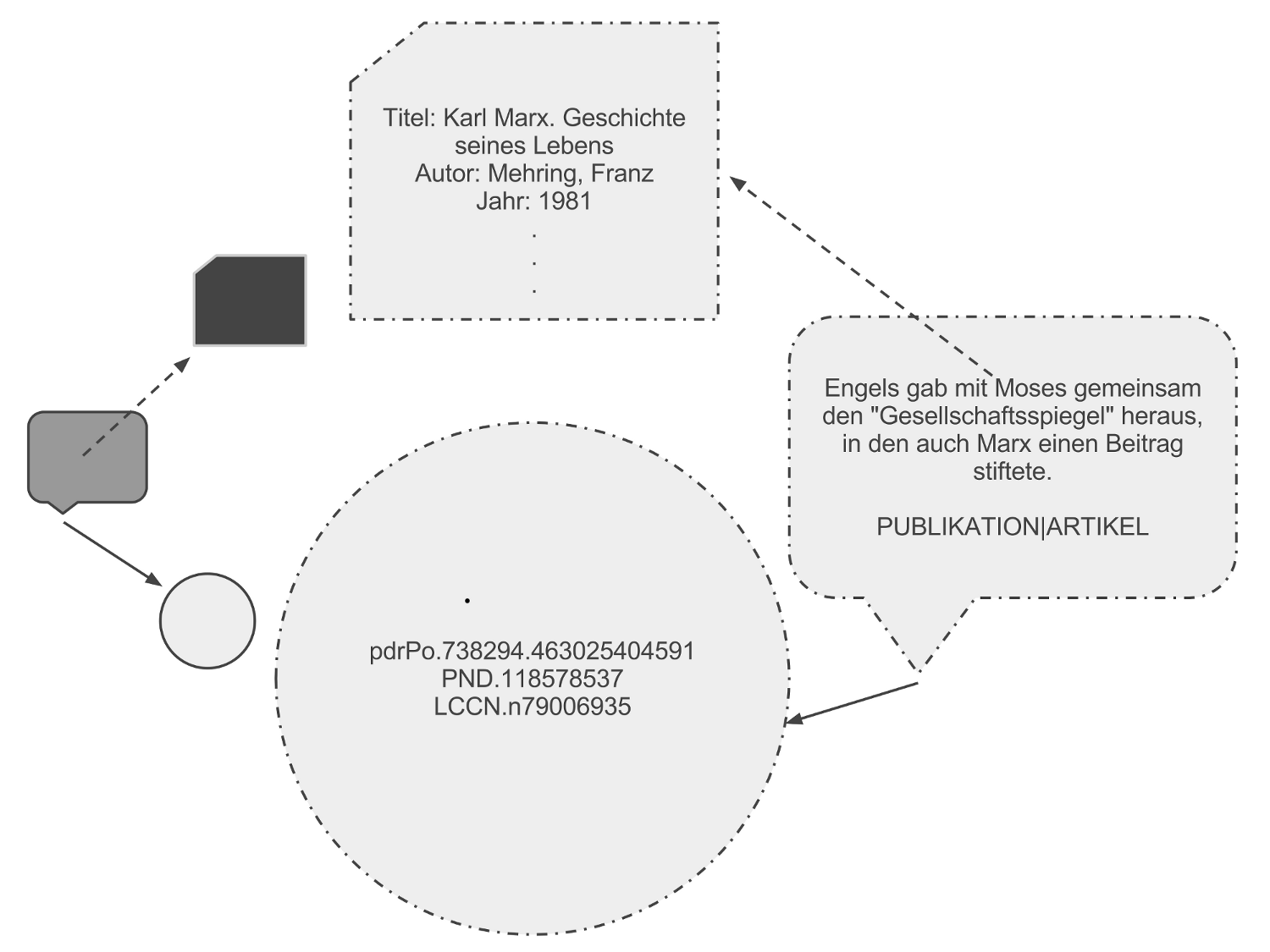

In den Quellsystemen liegen die Daten in Verbindung mit einem durch die Forschungsgruppen definierten Inhaltsmodell vor, welches zum Beispiel durch das Entity-Relationship-Modell einer MySQL-Datenbank definiert ist. Im PDR sollen die Daten jedoch in einer vom Inhaltsmodell unabhängigen Weise abgespeichert werden. Hierfür sieht das Datenmodell eine abstrakte Klasse von Objekten vor, die die allgemeinste Form repräsentiert, in der eine Personeninformation festgehalten werden kann und die in einer Aussage zu finden ist. Das heißt, Personendaten treten in Form von Aussagen wie zum Beispiel Edgar von Westphalen wurde 1819 in Trier geboren, 1848 vergrub er die Unterlagen des »Demokratischen Vereins«. Um deutlich zu machen, dass es sich um eine personenbezogene Aussage handelt, nennen wir personenbezogene Daten in unserem System ›Aspekte‹ einer Person. Gleichzeitig wird mit der Definition von Personendaten als Aussagen der diskursive Charakter unterstrichen, in den diese zumeist eingebunden sind. Für jede Personeninformation wird ein Objekt dieser Klasse instantiiert. Das Objekt selbst besteht aus einer XML-Datei, die die Personeninformation in der Form enthält, wie sie in der Quelle auftaucht. (siehe das <notification> Element in Abbildung 1).

Abbildung 1: XML-Objekt der Aspekt Klasse

Die Aspekt-Klasse ermöglicht das Anlegen von Personendaten unabhängig von einem bestimmten Inhaltsmodell. Vorhandene Inhaltsmodelle in Quellsystemen oder in Klassifikationsschemata von Forschungsgruppen können in Form von Metadaten in die Objektinstanz hinein kodiert werden. Sie bilden damit den oben angesprochenen Kontext ab. Im vorliegenden Beispiel befand sich die Personeninformation im Quell- system mit dem Kürzel ›AB‹ in einer Spalte ›Geburt‹ einer MySQL Datenbank. Daneben hat das PDR die Information zusätzlich noch mit dem Tag ›Lebensdaten‹ klassifiziert. Eine Referenz im <validation> Element verweist auf eine Quelle, die den größeren Kontext der Information beschreibt. Auch nachdem das Objekt bereits instantiiert wurde, kann die semantische Erschließung der Personeninformation beliebig erweitert werden, ohne dass dies Auswirkungen auf das Datenmodell hat. Genauso verhält es sich mit dem Inhaltsmodell im Allgemeinen. Da Inhaltsmodell und Datenmodell im PDR strikt voneinander getrennt sind, bringen nachträgliche Veränderungen im einen keine Schwierigkeiten für das andere mit sich. Vielmehr ergibt sich das Inhaltsmodell erst dynamisch durch die Organisation der tatsächlich vorhandenen Tags unter Verwendung der Pragmatic Data Integration.

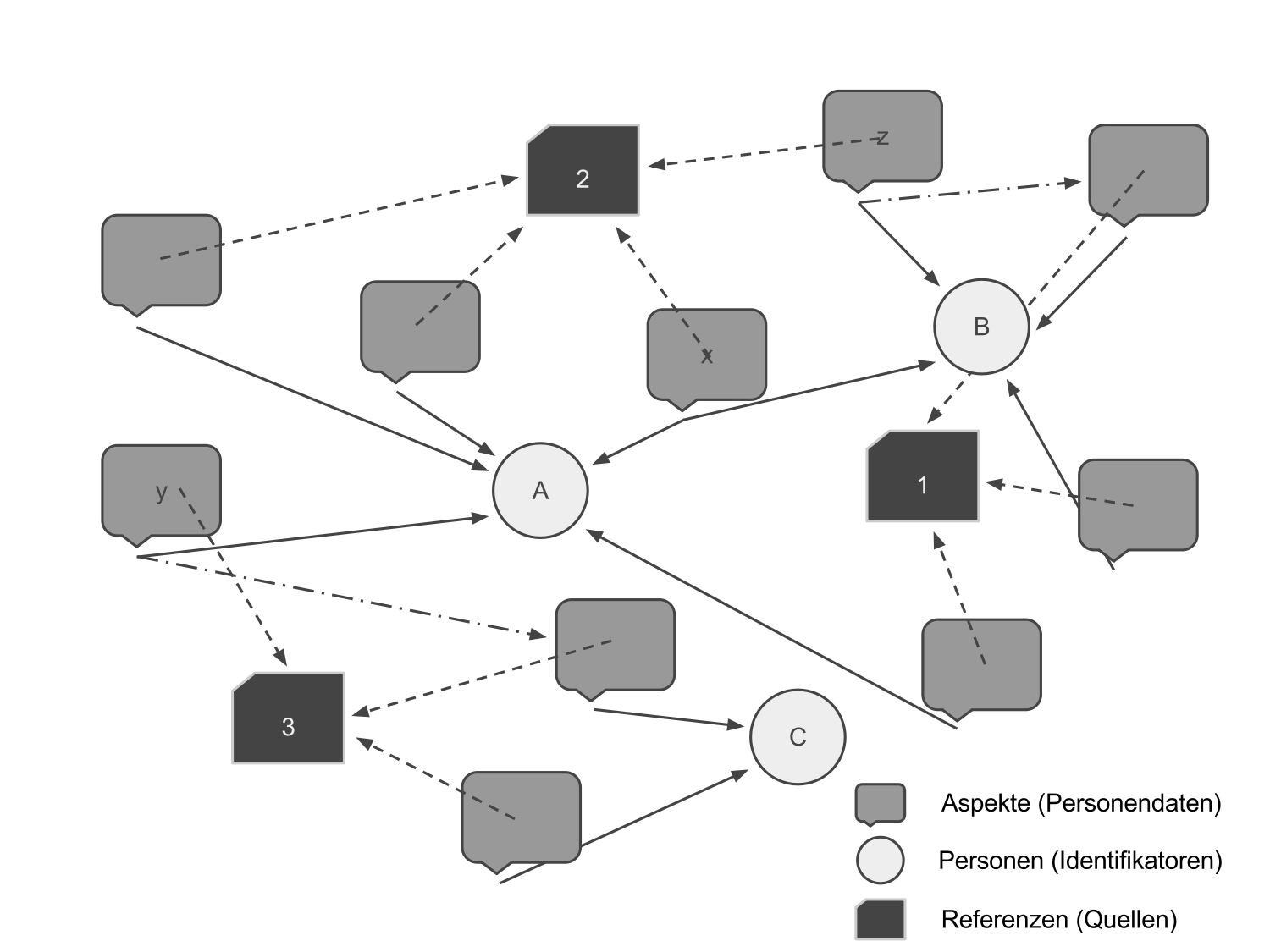

Neben der Aspekt-Klasse besitzt das Datenmodell des PDR noch zwei weitere Klassen. Das eine ist die Personen-Klasse und das andere die Referenz-Klasse. Letztere ist uns zuvor im <reference> Element begegnet und beschreibt eingehende Quellen und Quellsysteme, die den Kontext für eine große Menge an Personendaten bilden. Die Personen-Klasse hingegen macht aus den Daten eigentlich erst Personendaten, indem sie ihnen als Bezugsobjekt dient. Da das PDR Personendaten nicht als feste Eigenschaften einer Person begreift, sondern als Aussagen über eine Person, wird diese als eigenständiges Objekt instantiiert. Dieses Objekt beinhaltet ebenfalls eine XML-Datei, die nichts anderes wiedergibt als eine Liste mit Identifikatoren, zum Beispiel aus Normdateien wie der PND oder der LCCN. Daher besitzt ein Personenobjekt neben den Identifikatoren keine Pflichtfelder oder Kerninformationen, die fest zu ihm gehören. Die Anzahl der möglichen Personendaten, die zu einer Person als Aspekt-Objekte angelegt werden können, ist unbegrenzt. Dieser Weg wird der zuvor beschriebenen Problematik des Materials gerecht und sichert eine langfristige Flexibilität im Umgang mit Personen. Die Beziehungen zu Instanzen der Personen-Klasse werden ebenfalls in den Aspekt-Objekten deklariert. Das Zusammenspiel der drei Objekt-Klassen ist beispielhaft in Abbildung 2 wiedergegeben.

Abbildung 2: Zusammenspiel der Objekt Klassen des PDR

Wie bei der Semantik und den Referenzen können im <relationDim> des Aspekt-Objektes unbegrenzt viele Beziehungen deklariert werden. Dies erweist sich zum Beispiel als sinnvoll, wenn sich eine Personeninformation auf zwei Personen beziehen könnte. Im Aspekt-Objekt werden dann zwei Beziehungen zu unterschiedlichen Personen-Objekten deklariert. Eine Klärung des Vorfalls kann mit der Datenbank betrieben werden; sie muss nicht im Vorfeld erzielt werden. Auch lassen sich auf diesem Wege Beziehungen zwischen zwei Personen ausdrücken. So kommt es vor, dass in der Forschung unter Verwendung unterschiedlicher Quellen die Frage auftritt, ob zwei Personen nicht in Wirklichkeit eine Person sind. Mit dem beschriebenen Datenmodell lassen sich derartige Problemstellungen abbilden. Darüber hinaus ist die Deklaration von Beziehungen zwischen Aspekten möglich, deren semantische Verbindung vom Wissenschaftler ausgedrückt werden soll.

In der soeben beschriebenen Weise bildet das Zusammenspiel der Daten-Objekte eine Netzwerkstruktur, von der Abbildung 3 einen Ausschnitt zeigt. Personen A, B und C werden durch verschiedene Aspekte beschrieben, die alle auf den Quellen 1, 2 und 3 basieren. Der Aspekt x gibt eine mögliche Identität zwischen der Person A und der Person B an. Aspekt y beschreibt Person A, besitzt aber auch eine Beziehung zu einem weiteren Aspekt, welcher sich auf Person C bezieht. Hierdurch sind Person A und C indirekt miteinander verbunden. Das zugrundeliegende Datenmodell kann als graphenbasiert und objektorientiert bezeichnet werden. Dadurch besitzt es große Ähnlichkeiten mit graphenbasierten Datenmodellen, die zurzeit unter dem Begriff NoSQL diskutiert werden [20]. Ein erfolgreiches Beispiel einer solchen Datenbank ist neo4j[8]. Ein Vorteil dieser Art von Datenmodellen, der auch im PDR zu dessen Verwendung führte, beschreibt Neal Levitt wie folgt: »NoSQL systems are flexible enough to better enable developers to use the applications in ways that meet their needs« [21]. Damit bereitet es optimal die die Realisierung der Pragmatic Data Integration Methode vor.

Abbildung 3: Ausschnitt aus der Datenbasis des PDR unter Verwendung seines graphenbasierten und objektorientierten Datenmodells

In welcher Weise kann die Datenbank in den Forschungsprozess eingebunden werden? Verschiedene Gruppen und Einrichtungen erhalten die Möglichkeit, kollaborativ an den Personendaten zu arbeiten, ohne dass die Herkunft und die unterschiedlichen Perspektiven auf die Daten verloren gehen. Gerade durch das Festhalten verschiedenartiger Referenzen und Klassifikationen werden Hintergründe und Entstehungskontexte der Daten transparent, die für ihr Verständnis von essenzieller Bedeutung sind. Offene Diskussionen und Fragen können mit in das System transportiert und neue Fragen durch Clustering [22] der Daten erkannt werden. Im Sinne der Pragmatic Data Integration wird der Anwender durch die Formulierung semantischer Perspektiven in Form kleiner Tag-Gruppen oder Ontologie-Fragmente einen Ausschnitt der Daten bekommen, der im Sinne seines Interpretationshorizonts liegt. In diesen semantischen Perspektiven lassen sich dann konkrete Suchanfragen formulieren. Hierdurch wird er in die Lage versetzt, eigene biographische Narrationen zu erzeugen.

Das Vielfältige im Einen – Ansätze für geisteswissenschaftliche Forschungsdatenbanken

Frei nach Marshall McLuhans zum Allgemeinplatz gewordenen Satz, dass das Medium die Botschaft ist [23], verstecken sich in der als Medium verstandenen Datenbank zumindest zwei Botschaften. Die erste ist eine inhaltliche Botschaft. So antizipieren Datenbanken durch ihre Konzepte und Datenmodelle das, was in ihnen überhaupt erfass- und auswertbar ist, und konstruieren so den Raum potenzieller Antworten. Die andere Botschaft baut darauf auf. Sie richtet sich an die Forschungspraxis, das heißt, sie teilt dem Benutzer einer Datenbank mit, in welcher Phase seiner Tätigkeit und in welcher Forschungsepisode er sinnvoll auf sie zugreifen kann. Dieser Punkt ist nicht so banal, wie man zunächst vermuten könnte. Eine Bibliographiedatenbank adressiert die Recherchetätigkeit und steht damit vorwiegend am Anfang eines Forschungsprozesses im Fokus. Gleichzeitig sind Bibliographiedatenbanken in den meisten Fällen digitalisierte Kataloge. Das in ihnen vermittelte Wissen wird indexikalisch verwendet. Auf indexikalisches Wissen wird zurückgegriffen, wenn der Sinn nicht im Interpretieren der Antwort, also zum Beispiel in einer wahr/falsch-Rezeption liegt [24]. Das Ergebnis ist in einem Katalog das Objekt ›Buch‹ oder eine andere Ressource. Die Beziehung zwischen Datenbankeintrag und Ressource wird als notwendig betrachtet [25]. Bei der Benutzung einer indexikalischen Datenbank ist es nicht das Ziel, den abgebildeten Gegenstand zu problematisieren, sondern auf ihn zuzugreifen. Dies weist ihr eine ganz spezifische Position im Forschungsprozess zu.

Folgt man der Klassifikation von Datenbanken anhand ihrer zugrundeliegenden Wissenskonzepte und Forschungsfunktion weiter, so ist auch die quantifizierende Datenbank ein weit verbreiteter Datenbanktyp. [26] In ihm werden Thesen, die im Vorfeld aufgestellt wurden, durch Mehrheitsverhältnisse verifiziert. Das in ihm ausgedrückte Wissen ist weder als Hinweis auf etwas zu verstehen, noch als Repräsentation einer Bedeutung. Das Wissen der quantifizierenden Datenbank ist ein vergleichendes Wissen unter dem Vorzeichen numerisch zu erfassender Charakteristika in den Datensätzen. Damit dies möglich wird, setzt sie ein hohes Maß an Standardisierung der in ihr abgebildeten Inhalte voraus. Damit ordnet sich eine solche Datenbank ebenfalls an einer ganz bestimmten Stelle des Forschungsprozesses ein. Mit ihr lassen sich unter bestimmten Prämissen [27], die man wissenschaftstheoretisch teilen muss, Thesen verifizieren, die zuvor aus einer bisher nicht näher beschriebenen Auseinandersetzung mit den Forschungsgegenständen heraus entstanden sind.

Die im PDR zurzeit entwickelte Datenbank gehört zu keinem der eben beschriebenen Ansätze. Ihr Ziel ist es weder, die Inhalte respektive Personen, mit denen sie sich auseinandersetzt, auf einen Fundus an »relevanten Beobachtungen […] zu reduzieren« [28] und zu standardisieren, noch erschöpft sich ihr Sinn darin, als Quellenverzeichnis für die Erwähnung von Personen in den von der BBAW erforschten Textgrundlagen zu dienen. Die bisherigen Datenbankkonzepte unterstützen die Entwicklung einer Forschungsfrage vorwiegend am Anfang und am Ende. Sie machen Bedeutungsträger für neue sinnstiftende Prozesse verfügbar und dienen als Autorisierungs- und Legitimationswerkzeug für neu produzierte Sinnzusammenhänge [29]. Der Prozess der Bedeutungsgenerierung selber, das heißt die Phase wissenschaftlichen Arbeitens, in der auf der Grundlage vorangegangener Forschung neue Thesen aufgestellt und neue Inhalte generiert werden, wurde bisher wenig in datenbankspezifischer Form unterstützt [30]. Genau an dieser Stelle setzt das PDR an. Indem es Daten zusammen mit ihren Kontexten abbildet, eröffnet es – je nach Datenlage – einen Bedeutungsraum vielfältiger Diskursmöglichkeiten. Durch das Identifizieren der Bedeutungskontexte der Daten, das Vergleichen von Inhalten in Abhängigkeit von ihren Quellen oder das Arrangieren von Einzelinformationen zu neuen Sequenzen – wie im vorangegangenen Abschnitt beschrieben – kann sich das PDR als ein Hilfsmittel für explorative Prozesse bei der Verarbeitung von Wissen erweisen, wie sie für geisteswissenschaftliche Forschung von großer Bedeutung sind. Während die Bedeutungsstruktur in der indexikalischen Datenbank hinweisend und in der quantifizierenden Datenbank symmetrisch ist, ist sie in dem hier vorgestellten Datenbanktyp assoziativ. Entsprechend ihrem Grundcharakteristikum, Forschungsobjekte abzubilden, die in der beschriebenen Etappe des Forschungsprozesses kontingent erscheinen, schlage ich für diesen Datenbanktyp den Begriff polysemische Datenbank vor.

Das in diesem Abschnitt erfolgte Klassifikationsschema von Datenbanken zielt auf die Verarbeitung der in ihnen abgelegten Inhalte und auf die Einbettung dieser Verarbeitung im Forschungskontext ab. Es handelt sich deshalb um eine bewusst etisch orientierte Einteilung, die sich kom-plementär zur informationstechnologischen Typisierung versteht. Sie soll einen Beitrag zu Data Curation Milieus leisten, indem sie die unterschiedliche Verwendung von Daten in den Wissenschaftskulturen unter-streicht.

Dieser Beitrag und insbesondere das Konzept einer polysemischen Datenbank ist insofern als geisteswissenschaftlich orientiert zu betrachten, als dass er Frage nach den Bedingungen der Möglichkeit der Abbildung von geisteswissenschaftlichen Inhalten in einer Datenbank zum Ausgangspunkt hatte. Dabei geht es ihm nicht nur darum, eine traditionell geisteswissenschaftliche Denkfigur zu kopieren, sondern dem Tatbe-stand Rechnung zu tragen, dass die Probleme, auf die Geisteswissenschaftler bei der Gestaltung datenbankorientierter Anwendungen stießen, für diese Denkbewegung wiederholt den Anlass gaben. Als Generalproblem erwiesen sich dabei immer wieder »[...] die unabdingbaren Prozesse der Formalisierung und Standardisierung, die eine Umformung historischer Quellen in elektronisch verarbeitbare Daten mit sich bringt, [...]« [31], wie es Stefanie Rüther für die Geschichtswissenschaften formuliert. Die Reduktion und Vereinheitlichung von Bedeutung, die hier für historische Quellen beschrieben ist, wird aber nicht nur als notwendige Beschränkung des später Abfragbaren empfunden, sie birgt auch die Gefahr, Ergebnisse, die mittels einer Abfrage später überprüft werden sollen, durch die begrenzten Eingabemöglichkeiten vorwegzunehmen. Hierdurch kommt es zu einer zirkulären Forschungspraxis, die ihre Annahmen als ›Scheinrealitäten‹ [32] in der Datenbank verankert. Hinter diesem Befund artikuliert sich im Umkehrschluss jedoch auch das Bedürfnis, dass eine Datenbank gerade in den Geisteswissenschaften »[...] über das konkrete Forschungsergebnis hinaus möglichst vielen Fragestell-ungen offen steht [...]« [33]. Mehr noch: »Der Nutzen einer Datenbank hängt wesentlich davon ob, wie flexibel die gespeicherten Daten einsetzbar sind.« [34].

Mit der polysemischen Datenbank, wie sie bisher als Entwurf im PDR gestaltet wird, soll gezeigt werden, dass Formalisierungen und Standardisierungen von Bedeutung in der Arbeit mit Datenbanken nicht obligatorisch sind, sondern nur bestimmte Datenbankansätze betreffen. Auch gab es in der Vergangenheit zumindest auf konzeptioneller Ebene schon einige Versuche von Geisteswissenschaftlern, der gerade erläuterten Problemstellung mit den Mitteln ihres eigenen Faches etwas entgegenzusetzen, um die Verwendung von Datenbanken in ihrem Fach nicht aufgeben zu müssen. So versuchte eine in der transtextuellen Literaturwissenschaft nach Kristeva verankerte Forschergruppe mit dem Virtuellen Kafka Bureau ein Inhaltsmodell zu entwickeln, welches dem Konzept des transtextuellen Lesens gerecht wird[9]. Ziel ist es nicht, die als Datenobjekt fungierenden Text-Chiffren (Semantische Einheiten im Text) durch eine begrenzte Anzahl von Datenfeldern mit standardisierten Werten zu beschreiben und zu klassifizieren, um später eine innertextuelle Vergleichbarkeit oder strukturalistische Interpretation zu ermöglichen. Vielmehr soll sich um die Chiffren herum ein unbeschränktes Emergenzfeld aus Echotexten spannen, welches den Kafka-Text als polyphones Werk verdeutlicht [35].

Sowohl das geäußerte Unbehagen vieler Geisteswissenschaftler als auch erfolgte Versuche, Datenbanken in die geisteswissenschaftliche Forschung zu implementieren, sollten von informationstechnologischer Seite nicht unbeachtet bleiben. Ansonsten wird die anfangs wiedergegebene Irritation über die Data Dimensions in diesen Disziplinen kaum zu überwinden sein. Einen Versuch, Aspekte aus beiden Bereichen etwas zu systematisieren, stellte der vorliegende Text dar.